Coloquio: Advanced microscopy techniques to enable the discovery of molecular mechanisms that regulate cell migration

- 12-06-2025 14:00 |

- Aula Federman

El ICTP y la ICO premian hoy con el "Gallieno Denardo Award" al profesor del DF e investigador del IFIBA, Dr. Christian Schmiegelow por sus contribuciones a la óptica y la fotónica.

El premio, que entregan estas prestigiosas instituciones desde el año 2007 está destinado a jóvenes investigadores menores de 40 años por sus importantes contribuciones científicas y la promoción de la ciencia en países en desarrollo.

*Por Lis Tous

Lee filosofía desde los dieciséis años: era su entretenimiento durante el viaje en tren hacia la escuela. “No creo haber entendido la lógica de Hegel en ese momento, pero aprendí que podía pensar las cosas de otra manera”, dice Hernán Solari, investigador del IFIBA que acaba de publicar Una visión constructivista sobre la Mecánica de Newton en Foundations of Science. Mucho más tarde, en lo que él llama “un esfuerzo de pensamiento crítico dirigido hacia los fundamentos” se pregunta por los axiomas de Newton, de dónde vienen, cómo pueden pensarse, y cómo es posible generalizarlos en “el camino de la unidad de la razón que buscara Kant”.

¿Cómo empezaron a interesarte los fundamentos filosóficos de la teoría de Newton?

Mi preocupación, yo diría mi obsesión, siempre fue mirar qué hay detrás de las cosas. Cuando dictamos Física 1 o Mecánica enseñamos las leyes de Newton, podemos brindarle a los estudiantes algo de intuición sensible, experiencias que pueden hacer para aceptar esas proposiciones en el caso de la primera ley - el Principio de inercia - y de la tercera ley - Principio de acción y reacción -; pero para la segunda ley no hay intuición posible. El desafío es pensar de qué manera transmitirla. En un momento creí que la solución era leer al mismo Newton para conocer cómo él lo había pensado en su libro Los Principia, pero su texto está axiomatizado. Recién en la tercera edición, en el comentario del primer capítulo él discute, aunque de manera confusa, las intuiciones de las cuales partió su razonamiento; ahí aparecen sus ideas del espacio y el tiempo absolutos, pero yo diría que no termina de convencer. Entonces, nosotros nos preguntamos por los fundamentos que conducen a estas ideas, que por lo menos nos parezcan aceptables, las razones que hay detrás de las leyes. Ahí es cuando nos dimos cuenta de que lo que estaba operando era un principio de no arbitrariedad.

¿Cómo entienden a la arbitrariedad?

Estrictamente hablando, la arbitrariedad es la falta de razón. Me interesa hace muchos años la dialéctica entre lo objetivo y lo subjetivo, el conocimiento es ese diálogo. De alguna manera el sujeto está influyendo sobre lo que está conociendo, ocurre un proceso de ideación que “contamina” a lo real, aquello que está afuera. Entonces, cómo acceder a lo real cuando todo lo que tenemos está contaminado por el sujeto, que no es individual sino el sujeto de la cultura, el sujeto histórico. De alguna manera, aparece la idea de que hay que suprimir al sujeto, entrar en la categoría de lo intersubjetivo en términos de Hegel. Nuestro trabajo es básicamente ver hasta dónde podemos liberarnos de la arbitrariedad del sujeto y cuánto nos ofrecía esa opción para construir de nuevo las leyes de Newton.

Y en ese sentido, en el trabajo realizan una matematización del Principio de No Arbitrariedad, un concepto de Leibniz...

Hay mucho de Leibniz en nuestro trabajo. Por un lado el programa de Descartes y Leibniz de matematización de la filosofía natural, por el otro, cómo Leibniz utilizaba el principio de razón suficiente -en su correspondencia con Clark, por ejemplo- que traducido a su forma más corta dice: "Si no hay razón para ello, no debemos hacer diferencia".

Nosotros lo ampliamos a una forma frecuente en la argumentación matemática: si por necesidad de la exposición debo introducir elementos que no responden a la razón -arbitrariedades- los resultados que se adquieran por este proceso deben obtenerse de manera equivalente con cualquier elección arbitraria de esos elementos. Es decir, que debe haber una función que me lleva de uno a otro caso, y funciones que puedo combinar para viajar por el conjunto de las arbitrariedades. Esto resulta en la matematización del principio de Leibniz asociándole una estructura de grupo. El espacio de Leibniz cumple con el requisito que lleva su nombre, pero si a ese espacio le sumamos la presentación de Descartes en términos de sistema de referencia, debemos introducir arbitrariedades. Las llamadas propiedades del espacio como homogeneidad e isotropía son requerimientos de la razón para eliminar la arbitrariedad del espacio referencial, al que llamamos subjetivo, que en el niño es el propio yo, el sujeto, la referencia.

Entonces, la diferencias, no surgen de la empiria, las propiedades surgen como necesidad de supresión de la arbitrariedad, son condiciones impuestas por la razón a algo que acabo de inventar: el espacio subjetivo, el espacio práctico que usa Newton. Después de introducir el tiempo como la medida del cambio, podemos hablar del cambio en las posiciones relativas, es decir, la velocidad relativa que cumple el requisito de Leibniz e introducir la velocidad subjetiva por la identificación del observador que dice "yo no me muevo". La remoción de ésta arbitrariedad la realiza la transformación de Galileo, que así deja de ser empírica como se suele argumentar, sin explicar el cómo de esa conclusión, para pasar a ser un requisito de la razón.

Si la arbitrariedad es la falta de razón, la no arbitrariedad es la negación de la negación, es decir la razón que se alcanza atravesando su opuesto. Este principio de racionalidad aparece en muchas ocasiones sin que podamos dar cuenta de él más que intuitivamente. Cada vez que percibimos un trato dispar de quienes consideramos iguales nos quejamos de la arbitrariedad y de la injusticia. El imperativo categórico de Kant, "actúa de tal modo que la norma de tu conducta sea aplicable a todos y universalmente válida", podría resumirse en "se razonable" y desplegarse con NAP. La igualdad ante la ley que proclaman las constituciones de los estados republicanos, es otro ejemplo. Como lo es el Principio de Relatividad que parece venir de la nada, principio empírico dicen Poincaré y Einstein. ¿A qué observaciones y experimentos refieren? pregunto yo, olvidan mencionarlos. Poincaré indica que hay algo más, que no pensar así le resulta repugnante. ¿Repugnante? si, como nos repugna la injusticia por ejemplo. Lo que intuyen es el Principio de No Arbitrariedad.

Segun Husserl hay una diferencia entre intuición simple o natural e intuición filosófica. En la primera las cosas se nos aparecen como ciertas sin más y así las aceptamos, en la segunda ponemos un control racional, una reflexión sobre el propio proceso de construcción de la idea. De esta manera, por la consciencia de la ideación, empiezo a estar en condiciones de saber cómo son los aportes a eso que me resulta cierto o aceptable, ¿qué viene de lo observado? ¿cuánto puse de mis ideas previas y de mi razón en lo ideado? ¿cuál es su forma perfeccionada? Esta intuición filosófica no es lo más común en los físicos, predomina en nosotros lo que se ha dado en llamar "realismo metafísico". El realismo metafísico ignora el proceso de producción de las ideas y de esta forma saca al sujeto de la escena, se engaña pensando que es objetivo por el solo hecho de no tener consciencia del sujeto. El espacio que es una construcción de la mente es tan real como mi perro que envía señales sensoriales de todo tipo. No niego que sean ambos reales pero la naturaleza de su realidad no es la misma y confundirlas tarde o temprano tiene consecuencias.

¿Y cómo aparecen Jean Piaget y Rolando García en esta reconstrucción?

Las contribuciones de Piaget en referencia a estas ideas se refieren al espacio de Newton como “el espacio del niño”, que está en el centro de la escena. Es un espacio subjetivo pero esta subjetividad se puede reprimir, en el sentido que puede comunicarse a otros. La intersubjetividad habla de una estructura común en todos nosotros, entonces, si algo es objetivo deberá ser también intersubjetivo. Estas son cuestiones que se plantearon desde muchas disciplinas; Kant, por ejemplo, que era físico, hablaba desde la filosofía sobre los “a priori” del conocimiento y en esos textos discute el espacio, el tiempo. Como no puede dar cuenta de ellos dice que son intuición pura. Luego, Husserl desde la fenomenología y Piaget puntualmente sobre el espacio y el tiempo van a decir que son construcciones del ser. Esto es un antecedente que nos permite pensar las teorías físicas; y ese es el programa, no pensar “hacia adelante”, es decir todo lo que podemos hacer sabiendo mecánica, todos los aparatos que se puedan construir.

Una razón donde lo consecuente está implícito en los antecedentes, es el juicio analítico de Kant. En cambio, nosotros queremos ir “hacia atrás”, el juicio sintético, el juicio crítico. O, en términos de Piaget y García, buscamos hacer rebasamientos de lo particular hacia lo general.

¿Cuáles son puntualmente los elementos conceptuales que aportan Piaget y García desde su epistemología constructivista?

Piaget y García tienen un libro en común que se llama Psicogénesis e historia de la ciencia, es el único libro de Piaget que salió primero en castellano. En ese libro ellos tratan de argumentar que existe un paralelo entre la forma en que se desarrolla el conocimiento en las etapas de desarrollo del ser humano, de la misma manera en que progresa el conocimiento en la humanidad. Y, entonces, estudia la historia del álgebra, la historia de la física… Trabajan la idea de rebasamiento, aquello que conocemos por separado y que luego se contemplan en un universal, en algo que las contiene a todas como casos particulares. Por lo tanto, no es que lo nuevo reemplaza a lo viejo, sino que lo viejo queda contenido en lo nuevo y, a la vez, es el soporte de esta nueva mirada. Es la dialéctica entre lo universal y lo particular, que no pueden distinguirse claramente uno del otro. Entonces, el niño progresa -según Piaget- a partir de sucesivos rebasamientos, que podríamos pensarlos también como abstracciones. En algún momento se detiene, la persona encuentra el límite de su construcción. Trabajar en los rebasamientos de la física es ir al lado duro del asunto, y es en lo que nosotros nos divertimos.

*Por Pablo Mininni

El último 19 de noviembre una de las presentaciones orales mas anticipadas de la reunión anual de la División de Fluidos de la Asociación Americana de Física apareció en diarios y revistas del espectáculo. Los organizadores de la reunión, a la que asisten cada año más de tres mil personas, no pudieron conseguir para esta presentación un recinto lo suficientemente grande y el público se acumuló en las puertas.

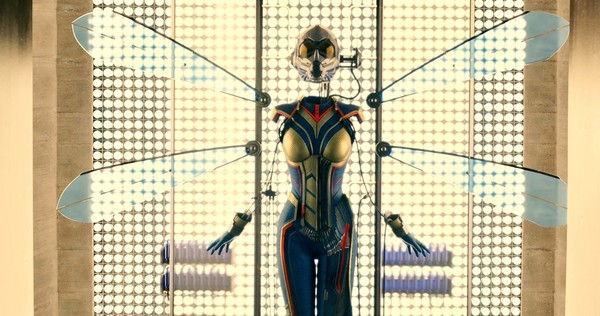

La charla tenía un título -como menos- llamativo: “Ant-Man and The Wasp: Helping Marvel superheroes breathe”. Ant-Man es un superhéroe de Marvel que puede encogerse al tamaño de una hormiga, o crecer por encima de los treinta metros de altura y convertirse en un Goliat. Creado por los legendarios Stan Lee, Larry Lieber y Jack Kirby en 1962, alcanzó la fama fuera del mundo de los cómics en dos películas recientes de Marvel Studios. The Wasp (la avispa), creada solo un año después, es su versión femenina y en los cómics es una de las fundadoras originales de Los Vengadores. Y aunque el interés de la prensa del espectáculo por estos temas puede ser entendible -las películas de superhéroes pueden facturar mas de 500 millones de dólares-, el interés que despertó esta charla y un paper reciente de los mismos autores es un fenómeno propio de otro universo.

Mientras Ant-Man y The Wasp reducen su tamaño utilizando un traje especial -y unas muy dudosas partículas fundamentales no descubiertas por el momento-, mantienen su masa y su fuerza original. Y aunque el cambio de tamaño podría ser motivo más que suficiente para dudar sobre la verosimilitud científica de toda la historia, los autores de este paper consideraron desde el punto de vista físico los problemas que estos cambios pueden generar a los cuerpos de quienes utilizan los trajes.

El trabajo fue publicado en 2018 en una revista cuyo nombre es de por sí gracioso: A. Staples y M. Mikel-Stites. "Ant-Man and The Wasp: Microscale respiration and microfluidic technology”. Superhero Science & Technology 1, 2018 (DOI: 10.24413/SST.2018.1.2474) https://journals.open.tudelft.nl/index.php/superhero/article/view/2474

Para cerrar este año 2018, y como lectura ligera para iniciar el verano, les recomiendo una mirada a este trabajo. Cada cual puede tener sus propias razones: conocer algo sobre la física de los superhéroes, un tema que es cada vez más usado para despertar vocaciones por la ciencia en los adolescentes; satisfacer una curiosidad (¡o algún gusto culposo!) por personajes que se visten con su ropa interior por encima de sus pantalone; poder comentar a sus amigos que en otros países del mundo los científicos también dedican parte de su tiempo a pensar estupideces; o simplemente, divertirse un poco con el uso que hacen los autores de conceptos físicos para intentar explicar cómo funcionan las cosas, aun en situaciones un poco delirantes.

Los autores, que cuando no dedican su tiempo a pensar en la física de los superhéroes trabajan en el estudio de la dinámica de fluidos biológicos, se concentran en este paper especialmente en temas de microfluídica, y en cómo los dispositivos actuales permitirían que Ant-Man y The Wasp respiren cuando se reducen al tamaño de un insecto. Uno de los principales desafíos que deben resolver estos superhéroes tiene que ver con el volumen de aire que pueden tomar sus pulmone: al reducirse en tamaño la cantidad de aire que pueden tomar en cada bocanada también se reduce, y se vuelve comparable a la que respiran los escaladores cuando se encuentran por encima de los ocho mil metros de altura (aunque en este último caso no se debe a un cambio de tamaño, sino al cambio en la densidad del aire con la altura). Pero como en el caso de los escaladores del Monte Everest, sin aclimatación o ayuda respiratoria, la falta de oxígeno puede generar complicaciones que pueden culminar en la muerte, o aún peor, pueden hacer peligrar la aparición de nuevas películas sobre Ant-Man y The Wasp.

Con un poco de ingenuidad y algo de publicidad (al fin y al cabo, el paper es también una forma de promocionar algunos resultados previos del mismo grupo sobre la microfluídica de la respiración en insectos), los autores discuten en detalle qué dispositivos microfluídicos sería necesario usar para asistir a la respiración de los superhéroes, y qué tipo de válvulas, compresores, bombas y tuberías se deberían utilizar. Y no contentos con esto, también discuten algunos aspectos sobre los cambios en el metabolismo de los superhéroes asociados al cambio de tamaño, y cómo estos cambios impactarían en la dinámica de fluidos en sus cuerpos. Con un largo de 16 páginas, el paper se lee rápidamente, y por encima de todo, entretiene. ¡Felices vacaciones!

Pablo Mininni es profesor en el Departamento de Física en Exactas-UBA e Investigador del CONICET.

La profesora del DF e investigadora del IFIBA recibió el Premio Nacional L’Oréal-UNESCO “Por las Mujeres en la Ciencia” 2018 por su el proyecto “Inmovilización de nano adsorbentes en membranas nanofibrosas electroestiradas para remoción de contaminantes en agua dulce”. El programa busca premiar la excelencia científica, a través de la promoción y el estímulo a la participación de las mujeres en el ámbito científico.

"El agua dulce es un recurso finito, vital para el ser humano y esencial para fabricar sus alimentos y cuidar su salud. Son varios los enemigo que acechan el agua dulce, entre ellos se encuentran el Arsenico (As) y los que se llaman compuestor Organicos Volatiles (VOC) entre los que están el benceno, toloeno, etilbenceno y xileno. En el proyecto ganador del Premio L´Oreal Unesco con el apoyo del CONICET, el grupo de investigación propone fabricar membranas poliméricas nanofibrosas electroestiradas con inmovilización de nanopartículas o grupos funcionales capaces de absorber As ó separar VOCs del agua contaminada. Los hallazgos de este estudio podrían proporcionar una nueva tecnología con potencial de reemplazar los nanoadsorbentes no inmovilizados utilizados en remediación de agua con reactores avanzados de flujo. Este es un enfoque proactivo que anticipa una solución a los peligros latentes de liberar nanopartículas en nuestro medio ambiente. Concretar nuestra propuesta permitiría el crecimiento en la formación del grupo de investigación para impulsar innovación de tecnologías aplicadas a remover contaminantes del agua para consumo humano e industrial mediante la utilización de membranas.", Silvia Goyanes.

En los medios:

https://exactas.uba.ar/noticias/un-loreal-para-goyanes/

Investigadores del Laboratorio de Procesado de Imágenes (LPI) publicaron en Optics Letters un trabajo sobre la caracterización de canales cuánticos por medio de tomografía. La novedad es que a través de una arquitectura óptica simple -basada en moduladores espaciales de fase programable- el grupo logró caracterizar procesos generales en sistemas cuánticos fotónicos en espacios de Hilbert multidimensionales.

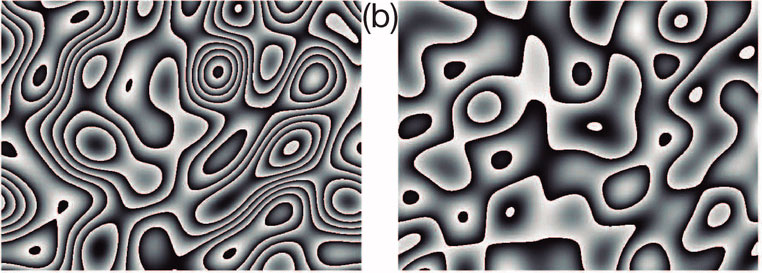

“Nos interesaba mostrar, por un lado, la reconstrucción de fuentes de errores típicos en las distintas etapas de cómputo de un algoritmo cuántico; y, por otro, procesos turbulentos como los que suelen afectar las transmisiones de información a través de la atmósfera. Esto es de suma importancia, ya que nos permite reproducir procesos reales interesantes en un ambiente controlado”, explica Lorena Rebón, una de las autoras del trabajo.

Desde hace algunos años, el LPI desarrolla esta línea de investigación que incluye la generación, manipulación y caracterización de qudits para aplicaciones de información cuántica. Para transmitir información cuántica a lo largo de un canal de comunicación o para estudiar, por ejemplo, la dinámica de un sistema cuántico, es necesario realizar operaciones cuánticas en los estados elegidos para tal fin. Los fotones ofrecen la posibilidad de codificar la información en otros grados de libertad, tales como el momento angular orbital o el momento lineal que, a diferencia de la polarización, están descritos por una base de estados de dimensión mayor a dos.

Para poder corregir los errores de comunicación, los investigadores necesitan caracterizar el funcionamiento de los dispositivos involucrados y de los canales por donde se envía la información. Esto se realiza experimentalmente mediante la técnica de caracterización de procesos que se conoce como Tomografía Cuántica de Procesos. La información obtenida permite conocer cuál será la evolución que seguirá un estado cuántico arbitrario.

El experimento se basa en moduladores de cristal líquido que permiten caracterizar el efecto de un canal de comunicación cuántico -cuyo comportamiento es en principio desconocido- sobre el estado en el que actúa. “Debido a su versatilidad nos permite caracterizar procesos que actúan sobre estados de dimensión d, en principio arbitraria. Además, permite mostrar la capacidad de simular procesos complejos -como los que suceden en medios turbulentos- y, dependiendo de la intensidad de la turbulencia, recuperar la información inicial”.

Autores: J. J. M. VARGA, L. REBÓN, PEARS STEFANO, AND C. IEMMI.

“Characterizing d-dimensional quantum channels by means of quantum process tomography” (Optics Letters 43, 4398-4401) del 15 de septiembre de 2018.