Coloquio: Advanced microscopy techniques to enable the discovery of molecular mechanisms that regulate cell migration

- 12-06-2025 14:00 |

- Aula Federman

*Por Gastón Giribet

El 12 de julio pasado se anunció oficialmente un descubrimiento deslumbrante que, de ser confirmado, vendría a revolucionar la manera en la que observamos el universo. El descubrimiento tuvo lugar unos meses antes, el 22 de septiembre de 2017. Ese día, los detectores del observatorio Ice-Cube, en la Antártida, detectaron un neutrino que, según indicaran observaciones astronómicas de los días que siguieron, parece haber provenido de un astro brillante de la constelación de Orión, el blázar TXS 0506+056. Se trataría, así, de la primera identificación del origen de los rayos cósmicos que llegan a la Tierra y del inicio de un nuevo tipo de astronomía.

Rayos cósmicos provenientes de la constelación de Orión

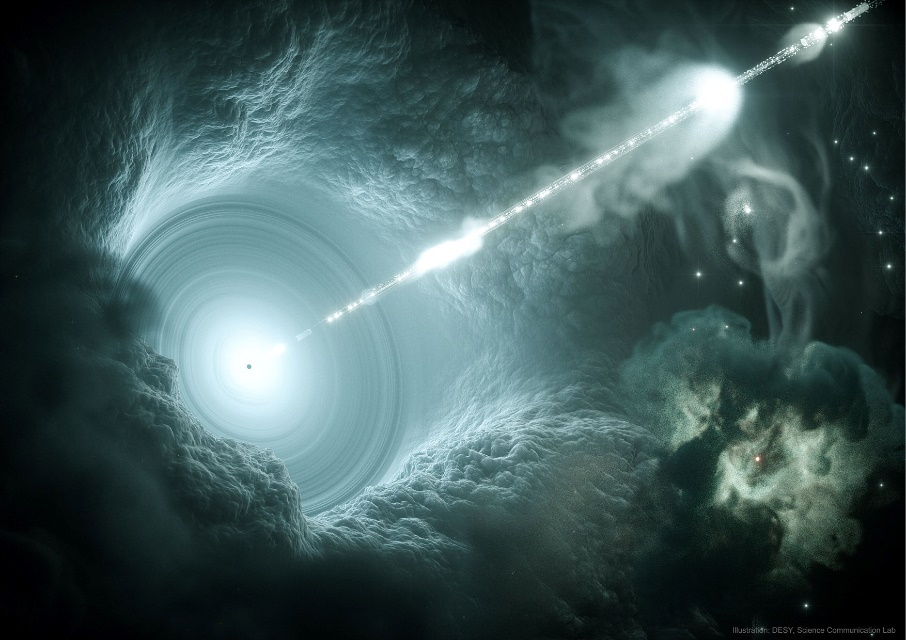

Un blázar es un fenómeno astrofísico de origen extragaláctico que está asociado a un tipo muy especial de galaxia con un núcleo activo. Muchas galaxias, si no todas ellas, tienen en su centro un agujero negro de enorme masa que es responsable de gran actividad. Violentos procesos astrofísicos ocurren en las inmediaciones de ese astro central, que recibe el nombre de agujero negro supermasivo debido a que su masa llega a ser varios órdenes de magnitud superior a la de las estrellas. La masa de un agujero negro supermasivo resulta proporcional a la de la galaxia que lo hospeda, un fenómeno para el que aún no existe explicación satisfactoria. En el caso de nuestra Vía Láctea, por ejemplo, el agujero negro que se halla en su centro es Sgr A*, con una masa de alrededor de 4 millones de veces la de nuestro Sol. En los casos de galaxias mayores, éstas llegan a albergar agujeros negros mucho más masivos, que alcanzan varios miles de millones de masas solares y que son fuente de gran actividad en el núcleo galáctico.

Los agujeros negros supermasivos generan un intenso campo gravitatorio que atrae la materia que se encuentra en sus inmediaciones. Así, estos astros terminan vistiéndose con un disco de acreción de materia ionizada, polvo, gas e incluso estrellas que son atraídas y eventualmente arrastradas a su interior. Toda esta materia, al encontrarse en agitación y fricción constante, arremolinada en una región reducida de unas fracciones de pársec cerca del agujero negro, alcanza temperaturas extremas. Esto lleva a la materia moribunda a emitir radiación de muy alta energía y propulsar partículas hacia el medio intergaláctico en forma de un jet colimado que se eleva en la dirección perpendicular al gran vórtice.

Lo que diferencia a un blázar de otra galaxia con núcleo activo no es sólo la existencia de jets ultraenergéticos sino también el hecho de que, por el azar de la distribución cósmica de los astros, uno de estos jets termina apuntando en la dirección de nuestro planeta. En resumen, los blázares son galaxias lejanas cuyos agujeros negros centrales emiten dos jets de partículas que se disparan en direcciones perpendiculares al torbellino de materia que ellos van ingiriendo, y uno de esos jets, providencial, nos ilumina a nosotros. Desde la Tierra, recibimos la luz y las partículas del chorro de energía, lo que aparece en nuestro mapa del cielo como una fuente de brillo inusual, una potente luz que nos habla de un violento ocurrir, allá, a lo lejos.

Representación artística de un blázar.

Los jets se componen de materia ionizada, partículas fundamentales y radiación electromagnética de diferentes frecuencias; en particular, rayos gamma. Su intensidad no es constante en el tiempo, ya que ésta depende de la cantidad de materia que el agujero negro supermasivo que les da origen esté consumiendo. Así, los blázares aparecen como objetos estelares de emisión variable, y experimentan períodos de mayor actividad que pueden durar algunos días. Sus fulguraciones pueden aumentar por lapsos breves y luego refluir a sus niveles medios.

El blázar TXS 0506+056, del que hablamos aquí, está ubicado a unos 3.700 millones de años luz de nosotros, en la dirección de lo que una arcaica manera de mapear el cosmos nos convence de llamar la constelación de Orión. La emisión de partículas, producto de una etapa de gran actividad de este blázar de Orión, es lo que se ha detectado recientemente en el observatorio Ice-Cube de la Antártida.

Centinela del hielo

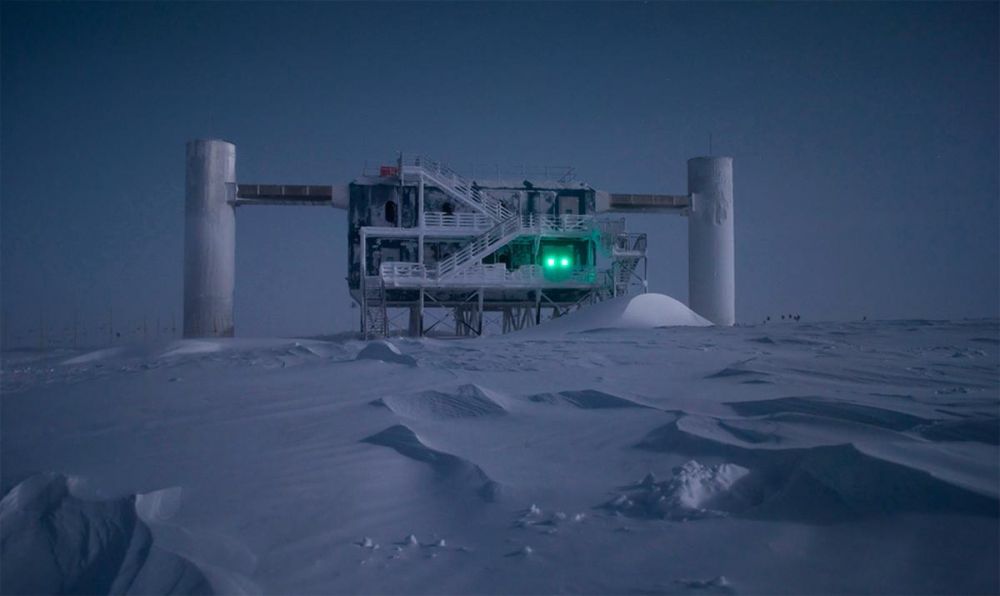

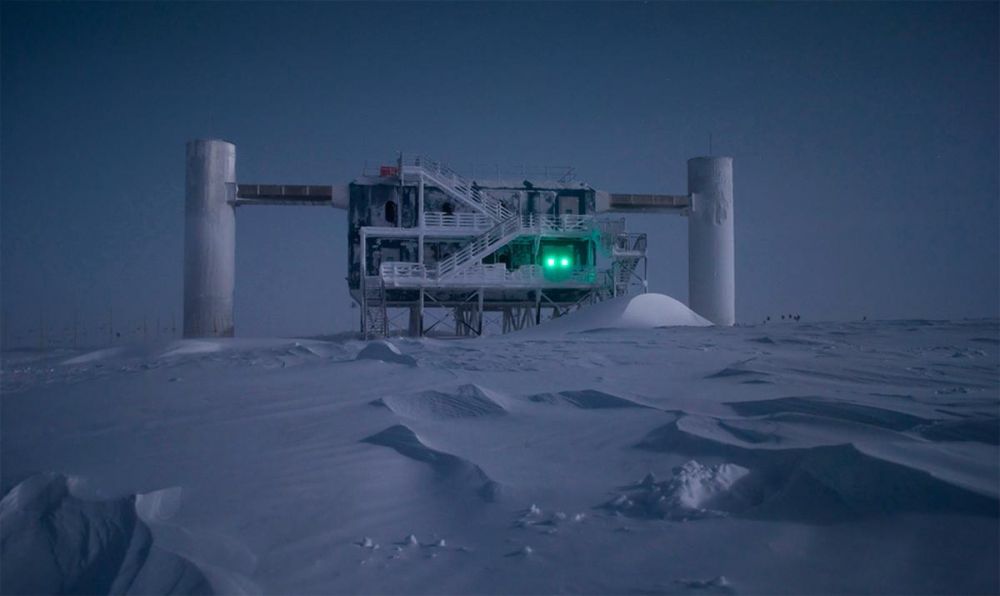

Ice-Cube es un observatorio de partículas emplazado en la Estación Científica Amundsen-Scott, en el continente blanco, muy cerca del polo sur. Fue construido con el propósito de detectar neutrinos, esas ligeras y escurridizas partículas que son renuentes a interactuar con la materia y que, por ende, son difíciles de atrapar.

Detectar neutrinos requiere, en efecto, de gran ingenio y de una sofisticada infraestructura, como la de Ice-Cube. El observatorio contiene 5.000 detectores enterrados en el suelo antártico, alojados en pequeñas cavidades talladas en el hielo, a pocos kilómetros de profundidad, dispersos en un volumen de un kilómetro cúbico de límpida agua congelada. Esos detectores, llamados módulos, se componen de cámaras muy sensibles provistas de un fotomultiplicador y una pequeña computadora. Enterrados allí, en el hielo austral, los módulos monitorean continuamente el gran volumen de hielo esperando rastros del paso de una partícula extraña que dispare la señal.

El observatorio Ice-Cube en el polo sur.

Los neutrinos, como decíamos, son reacios a interactuar con la materia, e incluso con ellos mismos. Sólo lo hacen por medio de la llamada fuerza nuclear débil –y de la fuerza gravitatoria, que es aún más débil–, lo que los hace indiferentes tanto a la mayoría de las reacciones nucleares cuanto a las interacciones electromagnéticas de cualquier frecuencia; es decir, los neutrinos son, literalmente, partículas elementales invisibles. Por consiguiente, aunque constantemente llegan la Tierra provenientes de todas las direcciones y de manera copiosa, su baja propensión a interaccionar con la materia lleva a los neutrinos a atravesar nuestro planeta sin siquiera notarlo. Sólo una pequeñísima, por lo general indetectable, cantidad de neutrinos termina por interactuar con algún átomo de nuestro planeta. Esto hace casi improbable que un neutrino, en su andar el universo, venga a impactar justo con un átomo del escaso kilómetro cúbico de hielo custodiado por los detectores de Ice-Cube.

Es precisamente gracias a esta baja probabilidad de detectar neutrinos –probabilidad que no es nula sino pequeña– que sabemos de ellos. Para entender esto debemos invertir el razonamiento de arriba: Si Ice-Cube viniera a detectar el paso de algunos neutrinos, la improbabilidad de tal suceso significaría que una inusual cantidad de ellos debió haber llegado a la Tierra en el momento de la detección. Sólo así se entendería que algunos ejemplares de tan escurridiza especie quedaran atrapados en nuestras redes. “El cardumen hubo de ser grande”, concluiríamos.

Eso ocurrió el 22 de septiembre pasado, y en algunas otras pocas ocasiones desde que Ice-Cube comenzó a funcionar, allá por finales de 2010. La primera detección apreciable de neutrinos en Ice-Cube tuvo lugar en 2013, y desde entonces algunas decenas de neutrinos en el rango de energías del tera-electronvoltio fueron observados en el hielo antártico. En particular, los detectores de Ice-Cube encendieron sus alarmas el 22 de septiembre pasado, y esta vez se trató de un evento muy especial.

Los eventos de septiembre

Lo que Ice-Cube detectó fue, en realidad, la radiación electromagnética producida por una serie de procesos que la colisión de un neutrino con un átomo desencadena. Al tratarse de detectores ópticos, los módulos de Ice-Cube no detectan el neutrino directamente –los neutrinos no interaccionan con la luz–. Lo que en realidad ocurre es que, al colisionar con las partículas que componen los átomos en el hielo, el neutrino genera una partícula llamada muón, que es similar al electrón pero unas dos mil veces más pesada. Este muón, al ser una partícula cargada eléctricamente, sí interacciona con la luz. Éste puede desplazarse por unos pocos metros dentro del hielo acarreando una porción del impulso que el neutrino original le supo propinar y finalmente emitir luz. Es la luz producida por el muón lo que los detectores ópticos colectan. Se trata, así, de una detección indirecta –como lo es todo ver– pero que aun así permite reconstruir la trayectoria y cantidades cinemáticas del neutrino que desencadenó la serie de procesos.

En el evento detectado el 22 de septiembre de 2017 lo que en realidad se vio fue eso, un muón; pero un muón muy sospechoso: La partícula apareció en las cámaras de Ice-Cube trayendo una inclinación inesperada, como si hubiera venido del centro de la tierra y no desde el espacio. Los muones se generan también en la alta atmósfera y, aunque muchos mueren en el trayecto, una gran cantidad de ellos llega a la superficie terrestre sin mayor dificultad. Por ello, la detección de muones provenientes del cielo no sería algo extraño. Lo que sí es difícil de explicar es que un muón con la energía del observado esa nochecita de la primavera austral provenga, no del cielo, sino de la misma masa terrestre. Los muones, a diferencia de los neutrinos, no pueden atravesar la masa rocosa del planeta sin desaparecer en el intento. Esto es síntoma inequívoco de que ese muón detectado acababa de ser creado por algo más, alguna partícula predecesora; ese muón no era sino el postrer aliento de un neutrino cansino que hasta ahí llegó, un neutrino proveniente de una fuente lejana.

A la pregunta de cuáles son las chances de detectar un neutrino de esa energía en el kilómetro cúbico de hielo monitoreado por el observatorio antártico le cabe una enfática respuesta: Bajísimas. De esto concluimos que, si vimos uno, pues es que debió haber una cantidad inusual de ellos; una copiosa lluvia de neutrinos debió acaecer ese día de septiembre.

El hielo y el cielo

Los detectores de Ice-Cube dispararon una alarma a los pocos segundos de haber detectado el paso de la partícula. Menos de un minuto después del hallazgo el evento ya tenía su nombre (Ice-Cube170922A) y se alertaba a distintos observatorios astronómicos en diferentes puntos del planeta, incluyendo los que operan telescopios a bordo de satélites. La idea era que, conociendo la dirección aproximada de la cual la lluvia de neutrinos parecía provenir –lluvia de la que sólo una gota había sido retenida por los detectores–, los telescopios enfocarían sus esfuerzos en esa región del firmamento para buscar allí evidencia de algún evento astrofísico que pudiera ser identificado como la fuente del inusual chorro de partículas.

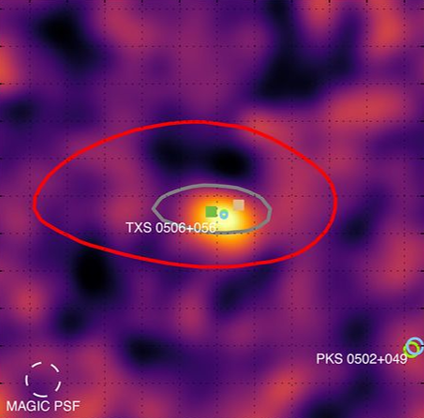

Imagen del blázar TXS0506+056

Cuando los fenómenos astrofísicos muy energéticos tienen lugar, por lo general las emisiones de materia y energía se producen en varias formas, en diferentes partes del espectro, en distintos tipos de radiación. Así, se esperaba que la emisión de neutrinos viniera acompañada de contrapartes electromagnéticas, en rayos X o en rayos gamma. Lo que hace a esta historia interesante es que tales emisiones compañeras fueron, en efecto, observadas.

Mediciones inusuales en el espectro de rayos X fueron las primeras en ser detectadas. Tal como se anunciaba un día después, el 23 de septiembre, casi una decena de fuentes activas en rayos X fueron identificadas en la región del cosmos de la cual los neutrinos parecían provenir; entre ellas, el blázar TXS 0506+056, hoy sindicado como el responsable. La confirmación vino unos días después, sobre fines de septiembre, cuando el telescopio de gran área LAT, a bordo del satélite Fermi de la NASA y con la misión de vigilar celosamente miles de blázares, anunciaba una inusual actividad en TXS 0506+056, en la constelación de Orión, de donde los neutrinos parecían provenir. Observaciones en radio y otras frecuencias también fueron realizadas.

La correlación entre la actividad inusual de rayos gamma en TXS 0506+056 y el arribo de una gran cantidad de neutrinos a la Tierra excitó a la comunidad. La coincidencia en la dirección angular y en el tiempo de ambos fenómenos deja pocas dudas. Como se suele decir en estos casos, aquello era ver la pistola humeando luego de haber oído el disparo.

A raíz de este descubrimiento, la colaboración científica Ice-Cube emprendió la tarea de revisar detecciones previas de neutrinos, acaecidas en los años anteriores, entre 2012 y 2017. Encontraron en ese registro más evidencia del origen de las lluvias observadas.

Esta es la primera vez que se identifica con tanta claridad la posible fuente de neutrinos de ese nivel de energía. Los neutrinos, aunque tienen una pequeñísima masa y, por lo tanto, no pueden viajar a la velocidad de la luz, sí lo hacen a una velocidad muy cercana a ésa. Es por ello que, aunque provenientes de miles de millones de años luz, la señal de rayos gamma del blázar y los neutrinos llegan a la tierra casi simultáneamente.

Este descubrimiento es de enorme importancia, dado que se trata de la primera vez que se identifica la fuente de rayos cósmicos de tal energía. Si bien es cierto que conocemos de la existencia de rayos cósmicos desde hace más de un siglo, que sabemos del origen extrasolar de la mayoría de ellos, que sospechamos del origen extragaláctico de muchos de ellos, y que tenemos teorías al respecto en las que bien confiamos, también es cierto que hasta el momento las únicas fuentes identificadas de los neutrinos que arriban a la Tierra eran dos: el Sol y la explosión de supernova observada en 1987 (denominada SN1987A). La detección de neutrinos en Ice-Cube el 22 de septiembre de 2017 y su correlato con la actividad del blázar TXS 0506+056 es la primera identificación del origen de un flujo de neutrinos de altas energías.

Sumando fuerzas para mapear el cosmos

Esto parece hitar el comienzo de una nueva etapa de la astronomía. Hasta 2015, la astronomía se restringía a la observación de la luz proveniente de los astros y la consecuente tarea de inferir qué procesos físicos podrían dar origen a la emisión observada. Y si bien la vastedad del espectro electromagnético nos permitió estudiar diferentes rangos de energías y diferentes tipos de fenómeno, el principio físico atrás de toda observación astronómica era el mismo: Tanto la astronomía convencional, como la radioastronomía, o la astronomía en el infrarrojo, o en el espectro de rayos X o de rayos gamma, son todas subdisciplinas basadas en lo mismo, la detección de la luz del proceso distante. La historia comenzó a cambiar en 2015, a partir de la detección de las ondas gravitacionales en los observatorios LIGO y Virgo. Se abrió entonces la ventana a un nuevo tipo de astronomía, que ya no percibe al cosmos simplemente por la luz que sus astros emiten, sino que lo hace escuchando también las perturbaciones del campo gravitatorio que esos astros, muchos invisibles, producen en su andar y encontrarse. Ahora, a la luz de esta observación de los neutrinos producidos por el blázar de Orión, una tercera manera de sentir el cosmos parece sumarse a las anteriores: Ya no son la electromagnética y la gravitatoria las únicas fuerzas con las que sentimos el universo, sino que ahora también la fuerza nuclear débil contribuye a la empresa. Es esta última fuerza la que genera los neutrinos en galaxias distantes que, luego de un trayecto extenuante de miles de millones de años luz, quedan atrapados allí, en los hielos del sur.

Referencias

[1] Neutrino emission from the direction of the blazar TXS 0506+056 prior to the IceCube-170922A alert, by the IceCube Collaboration, in Sciences, July 12th, 2018.

http://science.sciencemag.org/content/early/2018/07/11/science.aat2890.full

[2] Multimessenger observations of a flaring blazar coincident with high-energy neutrino IceCube-170922A, by the IceCube Collaboration, in Sciences, July 12th, 2018.

http://science.sciencemag.org/content/early/2018/07/11/science.aat1378.full

[3] Single subatomic particle illuminates mysterious origins of cosmic rays, in Nature, July 13th, 2018. https://www.nature.com/articles/d41586-018-05703-y

(*) Gastón Giribet, Profesor del Departamento de Física, Exactas, UBA. Investigador Principal en IFIBA de UBA-CONICET. Investigador del Centro de Cosmología y Física de Partículas de New York University.

GENis es un software diseñado para contribuir al esclarecimiento de delitos a través de coincidencias entre el perfil genético de una muestra de ADN con aquellos cargados en el sistema. La herramienta desarrollada íntegramente en Argentina busca efectivizar procesos en criminalística, como así también ayudar a resolver casos de desapariciones de personas o en la identificación de individuos víctimas de desastres masivos.

Ariel Chernomoretz es coordinador del equipo científico de GENis, y explica que uno de los objetivos del soft es brindar una herramienta a la justicia para sacar el máximo provecho de muestras genéticas encontradas en escenas del crimen, facilitando la posibilidad de incorporar en el análisis el uso de bases de datos locales, regionales y nacionales, y homologando al mismo tiempo un protocolo de trabajo. “Este es un proyecto que comenzó en 2014, ya está operativo en cuatro provincias y recientemente obtuvo las firmas necesarias para funcionar en otras catorce”, explica el profesor del DF, investigador en IFIBA de UBA-Conicet y director de un laboratorio en el Instituto Leloir.

“Es un proyecto súper interesante porque dialogamos con desarrolladores de soft, abogados y fiscales, en torno a temas de mucha actualidad, con profundas implicancias sociales, y cada uno hace su parte. Nosotros, desde la pata científica, si puede decirse así, buscamos tener una herramienta lo más confiable posible, acorde a estándares internacionales, con el objetivos de interconectar laboratorios y ser lo más eficiente posible”, asegura el físico.

La huella digital genética

El genoma de cada individuo tiene diferencias suficientes para identificar casi unívocamente una persona y diferenciarla de otra. La técnica forense consiste en utilizar unos marcadores que se encuentran en la parte no codificante del genoma, que son pequeños fragmentos de ADN con “poquitas letras”. De acuerdo a cuántas veces se repite esa “frase” en el perfil da como resultado una huella digital única, una especie de código de barras para los distintos marcadores que permite identificar individuos.

“La idea es tener un sistema con el que cotejar si hay match entre la evidencia de ADN levantada en un escena de crimen con alguna persona ya registrada en la base de datos; identificar reincidencia; encontrar la conexión de delitos cometidos en distintos territorios para unificar causas, etc.”, asegura Chernomoretz y agrega que otra posibilidad que permite el soft es el cotejo de datos en la búsqueda de personas desaparecidas, donde se vincula a la persona que ingresó como NN en una base de datos con la familia que lo está buscando”.

Según el investigador, el proceso de cotejo de correspondencia debe hacerse de manera eficiente, porque las bases de datos poseen volúmenes considerables. “Por ejemplo, si dentro de una determinada población tomamos a una persona cualquiera, ¿qué tan probable es que el matching haya ocurrido por azar? Para responder a esa pregunta utilizamos el p-value, una medida de la significancia estadística del match. Con la tecnología que se usa en la mayoría de los laboratorios se logran valores muy bajos de p-value, lo que da una confianza muy grande en los matchs, por lo tanto, se rechaza la casualidad y comienza a pensarse en la causalidad”.

Luego de cotejar los datos a través del software, los usuarios reportan los resultados al juez de la causa en cuestión. “Es importante decir que no puede idealizarse esta herramienta, los resultados deben ser ponderados en el contexto de otras evidencias y del propio trabajo del juez”, aclara.

Desafíos técnicos y políticos

“Hay situaciones complejas, como cuando en un escena del crimen se encuentran muestras de más de un aportante, eso implica deconstruir la señal para encontrar a los contribuyentes más probables. Lo que reportamos es un cociente de verosimilitudes, es decir, cuánto más probable es haber encontrado la muestra en cuestión dada la hipótesis del fiscal, por ejemplo, en contraposición a la hipótesis propuesta por el defensor. Entre dos posibilidades, el cociente nos dice qué escenario tiene mayor probabilidad”. El mismo tipo de estadística se utiliza para la búsqueda de personas desaparecidas, “tenemos un pedigrí formado por padres, hijos, sobrinos, nietos, y, en ese caso, medimos la posibilidad de que una persona pertenezca o no la genealogía familiar. La verosimilitud de un pedigrí es algo costoso computacionalmente, en ese caso utilizamos una técnica basada en lo que se conoce como redes bayesianas”.

Chernomoretz asegura que la puesta en uso de la herramienta suma complejidad porque involucra coordinar legislaciones de distintas provincias: “a veces, ni siquiera existen o si las hay, difieren mucho en los alcances que cada una plantea para las bases de datos”. Sin embargo, el soft tiene claras ventajas para el país, ya que “crea una comunidad de usuarios y desarrolladores locales, donde la interacción es muy fructífera, y donde aparecen nuevos desafíos todo el tiempo. Otra virtud es que es un soft open source, por lo que todos los algoritmos están publicados o por publicarse, y fue construído con software libre”.

La herramienta informática es financiada por la Fundación Sadosky a partir de un requerimiento de la Sociedad Argentina de Genética Forense y cuenta con el apoyo del Ministerio de Ciencia, Tecnología e Innovación productiva de la Nación. Sin embargo, compite en su implementación con el software desarrollado por el FBI, CoDIS (Combined DNA IndexSystem) que intenta imponer el Ministerio de Seguridad de la Nación. En este sentido el científico cuenta: “el soft importado se licencia de manera gratuita mediante la firma de acuerdos de uso -una licencia que se puede revocar- y es muy restrictivo por lo que no podemos conocer características de uso y difusión de su tecnología. Como es un sistema de caja cerrada, no se conoce bien qué hace. La licencia es gratis, aunque sabemos que nada lo es, tiene algunos costos. De todos modos, lo problemático es que se puede revocar la licencia de un momento a otro y si toda la justicia se monta sobre este sistema quedas desvalido. En cambio, GENis promueve la formación de recursos humanos en el área y para nosotros es una oportunidad de crecimiento muy grande a nivel local y también global, porque no hay muchos softs de este tipo”.

“Como encargado de la parte científica del proyecto la preocupación es cumplir con todos los requerimientos, validar el soft todas las veces que sea necesario a través de organismos competentes como el Banco Nacional de Datos Genéticos, el grupo de desarrollo de soft de la UBA, que se ocupa de validar todas las especificaciones que sean las correctas, es decir, que todo lo que se dice que el programa hace, se haga, y también de la Sociedad Argentina de Bioinformática y Biología Computacional”, concluye el físico.

* Por Susana Landau

Los primeros indicios de que las leyes de Kepler no predicen adecuadamente las curvas de rotación en cúmulos de galaxias fueron reportados por Oort en 1932 y Zwicky en 1933. Estos astrónomos encontraron evidencia de que la masa de cúmulos de galaxias debe ser mucho mayor a la masa luminosa correspondiente a las estrellas en esos cúmulos. Estas observaciones se confirmaron en 1970 cuando fue posible medir velocidades de rotación en galaxias espirales y no se observó la dependencia kepleriana esperada.

Para resolver este problema importante de correspondencia entre la predicción de la teoría de gravedad vigente (Newtoniana o Einsteniana) y los datos obtenidos mediante observaciones astronómicas, se postuló la existencia de la materia oscura, que no absorbe ni emite radiación electromagnética, pero que puede detectarse mediante sus interacciones gravitatorias. Según el modelo cosmológico estándar, constituye el 25 % de la materia del Universo. Si bien, no se ha podido detectar la materia oscura en los experimentos terrestres diseñados a tal fin, los resultados de la mayoría de las observaciones astronómicas que se utilizan para estudiar el Universo requieren de la existencia de materia oscura para poder ser explicados. A su vez, se han postulado teorías alternativas a la Relatividad General (RG) para describir la Gravitación, donde la modificación a la RG resulta en un predicción consistente con las observaciones, mientras que el modelo cosmológico estándar es necesario postular la existencia de materia oscura.

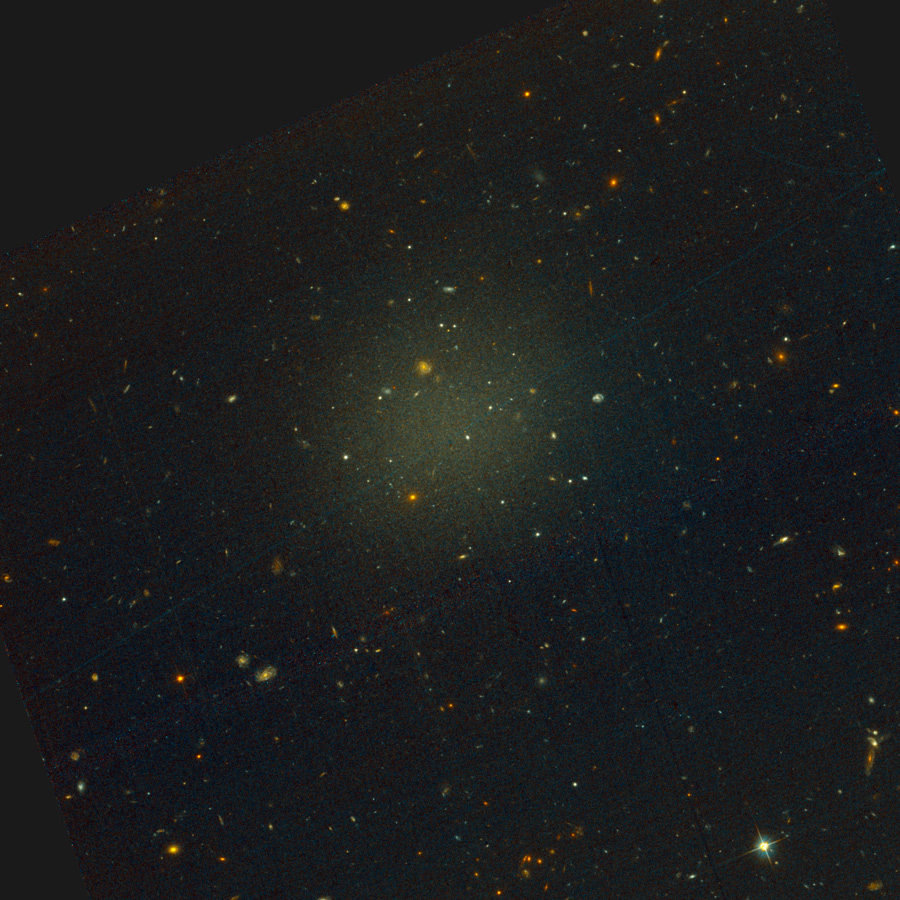

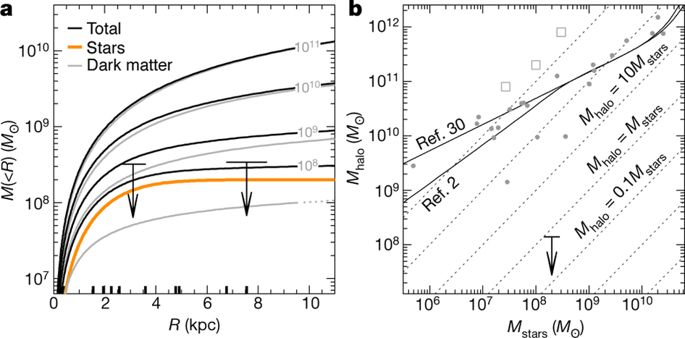

En este paper que recomiendo, un grupo de investigadores midió las velocidades radiales de diez objetos en la galaxia ultra difusa NGC1052–DF2, que tiene una masa estelar de aproximadamente 2x108 masas solares. Utilizando el método de los trazadores de masa (TME) calcularon la masa estelar de la galaxia, mientras que la masa del halo fue estimada con el método de la proyeccion de los radios de los sistemas de cúmulos estelares globulares. El resultado sorprendente es que el cociente entre la la masa del halo de la galaxia y la masa estelar de la misma es aproximadamente 1, cuando lo esperado es del orden de 400. Esto indica que no todas las galaxias tendrían un halo de materia oscura. Sin embargo, este artículo, lejos de descartar el paradigma de la materia oscura, lo afirma, ya que la ausencia de la misma, puede ser explicada por choques de la galaxia con otras durante su evolución. Por el contrario, las teorías de gravedad modificada que no incluyen la materia oscura, tendrían mayor dificultad para explicar esta observación.

1 A galaxy lacking dark matter P. van Dokkum et al. Nature 555, 629 (2018) doi:10.1038/nature25767

* Susana Landau es Investigadora del Instituto de Física de Buenos Aires, de UBA-CONICET.

* Por Enzo Tagliazucchi

El problema único que la consciencia plantea a la física

Lo que llamamos usualmente “consciencia” es idéntico a nuestra experiencia de existir como humanos. El “azul” del azul, el sufrimiento de un dolor de muelas, la pasión o la tristeza se experimentan de manera subjetiva y privada por cada uno de nosotros. No obstante, la evidencia científica sugiere fuertemente que cada una de estas experiencias privadas se relaciona con eventos físicos objetivos que ocurren dentro de nuestro cerebro.

La física intenta encontrar explicaciones de la naturaleza en su nivel más fundamental. ¿Cuál ese el rol de la física en la explicación de la consciencia? ¿Una hipotetica teoría unificada de la física debería ser capaz de incluir en su poder explicativo por qué la descarga de neuronas en el cerebro al ver el color azul conlleva también una sensación experimentada por dicho cerebro, y por qué la sensación de ver el color es cómo es, y resulta distinta a la de ver el color rojo?

En otras palabras, la mayoría de los científicos y filósofos cree que el cerebro tiene una propiedad única no compartida por ningún otro objeto físico en el universo conocido: un punto de vista. Existe “qué se siente ser un cerebro” pero no existe “qué se siente ser un electrón” o “qué se siente ser un agujero negro”. ¿Cómo da cuenta la física de esta singularidad?

¿Por que un fotodiodo no es conciente?

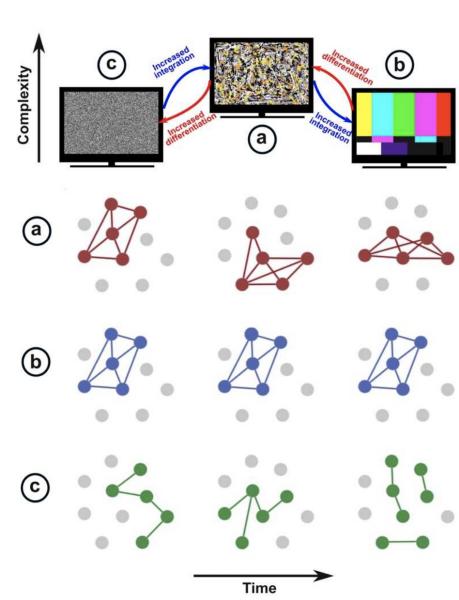

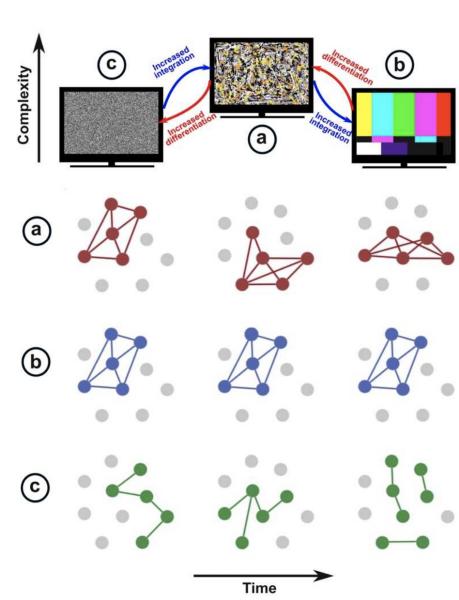

Una de las teorías más promisorias sobre la conciencia fue desarrollada por el psiquiatra y neurocientífico Giulio Tononi1. La teoría puede explicarse a partir de una serie de experimentos mentales sencillos en la tradición de la física clásica.

Consideremos un fotodiodo; un dispositivo capaz de detectar la presencia o ausencia de luz más allá de determinado umbral. Un ser humano también puede “trabajar” de fotodiodo decidiendo la presencia o ausencia de luz y reportándolo. Sin embargo, a pesar de que funcionalmente el ser humano y el fotodiodo desempeñan una misma tarea, el fotodiodo no posee una sensación consciente de la presencia o ausencia de luz, mientras que el ser humano sí lo hace. ¿Por qué un fotodiodo no es consciente?

La respuesta reside en el repertorio de estados posibles del fotodiodo: la presencia o la ausencia de luz. En teoría de la información, determinar el estado del fotodiodo determina 1 bit de informacion. En cambio, el ser humano puede percibir la ausencia o presencia de luz, pero además puede estar en una cantidad inmensa de otros estados: pensemos en todas las posibles experiencias visuales que vivimos y viviremos a lo largo de la vida. Especificar el estado del cerebro, dado su enorme repertorio de posibles estados, determina un valor mucho más elevado de información.

Este argumento aparentemente trivial se complica cuando consideramos que el ojo humano posee una resolución aproximada de 500 megapixels, pero existen cámaras digitales en la actualidad que empujan su límite de resolución hasta 400 megapixels, es decir, que pueden capturar un repertorio de imágenes comparable al del ojo humano. ¿Significa que una cámara de 400 megapixels es consciente de las escenas visuales que captura? La respuesta es que no, dado que una cámara digital no es más que una colección de un número enorme de fotodiodos que capturan luz de manera independiente. En cambio, en el cerebro existe un proceso de integración – la información se combina para generar una escena unificada en la cual la información contenida en el sistema total es más que la suma de las contribuciones de sus sub-partes, dado que las mismas no son estadísticamente independientes-.

Tononi concluye que la consciencia surge de un balance de integración-segregación en el cerebro. El repertorio posible de estados se maximiza si cada neurona dispara de manera independiente de las otras, pero en este escenario no ocurre integración de dicha información. Por otro lado, en un escenario donde dicha integración es máxima todas las neuronas disparan en conjunto, pero entonces el número de estados es igual al de un fotodiodo. Estos dos ejemplos pueden mostrarse en concreto con condiciones neurológicas y farmacológicas asociadas a la pérdida de la consciencia:

1. En una crisis epiléptica la corteza cerebral se comporta de manera “biestable” –las neuronas o bien disparan sincronizadamente, o bien entran en un estado de quiescencia;

2. Bajo la influencia del anestésico disociativo ketamina, las neuronas pierden la capacidad de comunicarse entre sí y por lo tanto aumenta el repertorio posible de estados, pero a la vez se pierde la capacidad de integración.

Ilustracion del concepto de integración, segregación y su relación con el de complejidad2. En el panel superior, a la izquierda se muestra un display de televisión con un máximo nivel de segregación (i.e. ruido blanco, cada píxel se comporta de manera independiente). A la derecha, existe una mayor correlación entre el comportamiento de los píxeles. En un punto medio la complejidad del sistema es máxima, cuantificada en base al balance de integración y segregación de la dinámica del sistema.

El panel inferior ejemplifica lo mismo con la evolución temporal del acomplamiento de un grupo de neuronas A, B y C que se identifican con las partes media, derecha e izquierda del panel superior.

El primer prequisito para desarollar un teoria física sobre un fenómeno es ser capaz de medirlo y cuantificarlo. Posteriormente, el desarrollo de una teoría permite entender el mecanismo fundamental por el cual dicha medición es funcional. Por ejemplo, los primeros termómetros informaban la temperatura en una escala arbitraria y fueron fundamentales para el desarrollo de la termodinámica. El desarrollo de la mecánica estadística y el concepto de microestado permitieron a Max Planck formular la tercera ley de la termodinámica y por lo tanto encontrar una escala absoluta para medir temperaturas.

En el paper que recomiendo, Casali y colegas desarrollan un “termómetro” de la consciencia humana basado en las consideraciones teóricas propuestas por Giulio Tononi3. Siguiendo la tradición de muchos experimentos en física, a diferencia de un termómetro tradicional -que se basa en el cambio de una propiedad física de un material en equilibrio térmico con su entorno- Casali y colegas proponen un “termómetro perturbativo” para medir la consciencia humana. Fundamentalmente, la medición consiste en la aplicación de un pulso magnético focalizado a través del cráneo y la medición simultánea de la respuesta neuronal generada por dicho pulso, mediante la adquisición de electroencefalografía, una técnica que permite inferir de manera indirecta la actividad de poblaciones sincronizadas de neuronas en el cerebro.

Un cerebro que carece de consciencia tiene, de acuerdo a la teoria de Tononi, un repertorio muy reducido de estados. Por lo tanto, una perturbación externa del sistema solamente generaría una respuesta “simple” resultante del tránsito del sistema a través de estos pocos estados. En la terminología de la física estadística, el espacio de fases de los potenciales estados del cerebro inconsciente se encuentra ampliamente reducido respecto del cerebro consciente. En este caso, el pulso magnético aplicado por Casali y colegas es capaz de producir una respuesta compleja resultante de recorrer un espacio de fases expandido.

Clínicamente, el método propuesto en este trabajo tiene una importancia fundamental: ya no que no requiere que el paciente sea capaz de procesar información sensorial ni producir una respuesta comportamental o motora. Este el caso de muchos pacientes supuestamente “vegetativos” que se diagnostican de manera errónea por asumir que la falta de reactividad motora a estímulos sensoriales es una señal de inconsciencia, mientras el paciente puede en realidad estar plenamente consciente pero “desconectado” de su entorno. El “termómetro de la consciencia” de Casali permite distinguir estos pacientes de pacientes verdaderamente vegetativos (y ya se encuentra en aplicación en ciertos hospitales). También permite distinguir con gran precisión a una persona despierta de una persona dormida o bajo distintos tipos de anestesia.

Hacia una mecánica estadística de la consciencia

El trabajo de Casali y colegas generó un gran impacto en la comunidad neurocientífica básica y clínica, pero pienso que paso lamentablemente desapercibido para aquellos que entendemos a la consciencia como el resultado de un sistema dinámico complejo. En primer lugar, la definición de consciencia de Tononi admite una reformulación en términos de complejidad. De hecho, si consideramos un modelo clásico de la mecanica estadística -el modelo de Ising- las fases de dinámica integrada y segregada corresponden a las fases sub- y super-críticas, y el punto óptimo dónde surge un comportamiento complejo es en la transición de fase de segundo orden del modelo. Es sabido que en dicho punto la susceptibilidad del sistema es máxima, es decir, el sistema presenta un cambio maximal ante una perturbación externa – un resultado análogo al observado por Casali y colegas. Este resultado y otros similares fueron reproducidos computacionalmente por trabajo de nuestro grupo de investigación en el cual simulamos el comportamiento a gran escala del cerebro mediante un modelo que presenta una transición de fase de segundo orden4, 5.

Por lo tanto, pienso que el interés del trabajo experimental de Casali y colegas para un físico es instalar la noción de que la consciencia puede ser cuantificada mediante métodos robustos y reproducibles y basados en teorias matemáticas concretas. En este sentido, pienso que la neurociencia de la consciencia se encuentra en una transición similar a la ocurrida entre la termodinámica clásica y la mecánica estadística a fines del siglo XIX.

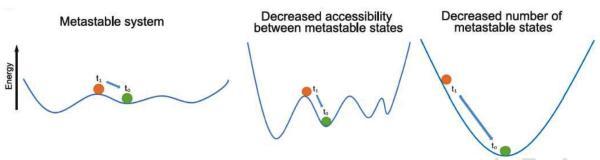

Quizas sea posible –y necesario- formular la teoria de Tononi en el lenguaje de la mecánica estadística. En esta formulación, el estado del cerebro no es más que un punto en un espacio de fases de enorme dimensión que representa todas las variables biológicas relevantes (conductancia de membranas, concentraciones de neurotransmisores, potenciales de acción viajando a lo largo de axones de neuronas, etc.). La dinámica de dicho punto puede verse atraída a ciertos puntos de metaestabilidad, es decir, a estados de cuasi-equilibrio que constituirían el “repertorio” de estados posibles del cerebro. La perdida de la consciencia se asociaría entonces a un cambio en dicho repertorio debido a la pérdida de puntos de metaestabilidad. No obstante, es posible que dicha pérdida sea solo aparente, causada por una pérdida de accesibildad entre puntos de metaestabilidad que continuan existiendo. Crucialmente, el experimento de Casali y colegas permite distinguir ambos escenarios dado que, al ser perturbativo, permite evaluar si el estado del sistema puede desplazarse entre distintos puntos de metaestabilidad de accesibilidad reducida. Esta situación se muestra en el diagrama utilizando el ejemplo de una pelota apoyada sobre una superficie con una serie de picos y valles, los cuales representan barreras de potencial y puntos de metaestabilidad, respectivamente (para que este ejemplo físico sea realmente quasi-estable debe asumirse una direccion transversal en la cual la dinámica es inestable)..

El diagrama ilustra el concepto de metaestabilidad de manera sencilla2. La evolución temporal del sistema desde t=0 a t=1 se muestra como el desplazamiento de una partícula en una superficie. Asumiendo dinámica inestable en la dirección transversal al diagrama, a la izquierda se muestra un sistema en el cual la energía de la partícula es suficiente para atravesar todos los puntos de metaestabilidad. En el medio, aumentar las barreras de potencial entre puntos causa que el sistema sea incapaz de transitar todos los puntos de metaestabilidad. Finalmente, en el escenario derecho solo existe un punto de metaestabilidad. El método perturbativo propuesto por Casali y colegas tiene la virtud de distinguir los últimos dos escenarios al entregar de manera externa al sistema energía en forma de un campo magnético localizado, y por lo tanto medir de manera perturbativa el repertorio de estados posibles del sistema, que se vincula -de acuerdo a la teoría de Tononi- con el nivel de consciencia.

¿Presenta la dinámica global del cerebro un repertorio de estados gobernado por una serie de puntos de metaestabilidad? ¿Qué mecanismo físico entre muchos posibles es responsable de esta metaestabilidad (e.g. ciclos heteroclinicos, ruinas de atractores, atractores no estables, etc.? ¿Qué mecanismos biológicos gobiernan la aparición/desaparición de puntos de metaestabilidad? ¿Es posible reformular completamente la teoria de Tononi utilizando las herramientas de la física estadísica? Éstas son algunas de las interrogantes que abre el apasionante experimento de Casali y colegas, que quizás quede en la historia como la primera cuantificación de la capacidad de poseer las sensaciones subjetivas que son la quintaesencia de nuestra identidad como seres humanos.

Referencias

1 Tononi, G. (2004). An information integration theory of consciousness. BMC neuroscience, 5(1), 42.

2 Cavanna, F., Vilas, M. G., Palmucci, M., & Tagliazucchi, E. (2017). Dynamic functional connectivity and brain metastability during altered states of consciousness. NeuroImage.

3 Casali, A. G., Gosseries, O., Rosanova, M., Boly, M., Sarasso, S., Casali, K. R., et al. (2013). A theoretically based index of consciousness independent of sensory processing and behavior. Science translational medicine, 5(198), 198ra105-198ra105.

4 Tagliazucchi, E., Chialvo, D. R., Siniatchkin, M., Amico, E., Brichant, J. F., Bonhomme, V., ... & Laureys, S. (2016). Large-scale signatures of unconsciousness are consistent with a departure from critical dynamics. Journal of The Royal Society Interface, 13(114), 20151027.

5 Tagliazucchi, E. (2017). The signatures of conscious access and its phenomenology are consistent with large-scale brain communication at criticality. Consciousness and cognition, 55, 136-147.

* Enzo Tagliazucchi es investigador del Instituto de Física de Buenos Aires de UBA-CONICET.

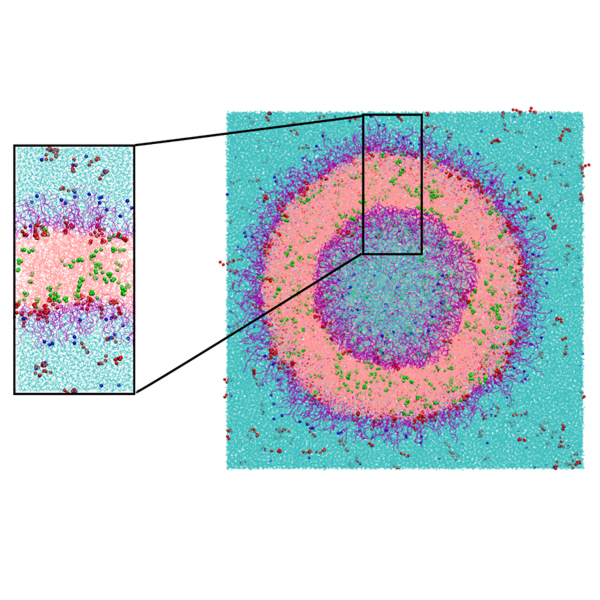

Las investigadoras del Departamento de Física y de IFIBA de UBA-CONICET Marta Ferraro y Mónica Pickholz junto a Damián Grillo y Juan Albano publicaron recientemente en The Journal of Chemical Physics el estudio de propiedades mecánicas de una membrana polimérica cargada con fármacos modelo y su implicancia en el diseño de polimerosomas aptos como nanocarriers -transportadores de tamaño nano- de fármacos. Su aplicabilidad es importante en la administración controlada de drogas, como en el caso de terapias oncológicas. La investigación fue llevada a cabo junto a Esteban Mocskos, del Departamento de Computación de Exactas-UBA y el Centro de Simulación Computacional para Aplicaciones Tecnológicas de CONICET; y Julio Facelli de la Universidad de Utah.

“La idea global de esta línea de trabajo es conocer con mayor detalle las características de ciertos nanocarriers poliméricos que mejoren alguna propiedad del efecto de fármacos, como su capacidad para llegar al sitio de acción, o bien, tener una actividad más prolongada. Nos interesa saber cómo -mediante herramientas computacionales- se puede apuntar un diseño racional, y así, disminuir la cantidad de pruebas, ahorrar tiempo de desarrollo y optimizar recursos”, explica Mónica Pickholz.

Un polimerosoma es una vesícula, una especie de cápsula que está formada por una membrana constituida por polímeros con un interior acuoso (ver figura adjunta). Según desarrolla Damián Grillo, “lo interesante de estos sistemas es que pueden encapsularse compuestos tanto en la membrana si la droga es hidrofóbica, o en el interior acuoso de los sistemas si es hidrofílica, aunque también se pueden encapsular ambas en simultáneo, cada una en su región, lo que puede resultar sumamente útil a la hora de abordar terapias combinadas”. Dado que las propiedades de un polimerosoma están fuertemente relacionadas con las características de la membrana que lo forma, el estudio de modelos de membrana representaría un enfoque simplificado para determinar propiedades del polimerosoma completo.

Marta Ferraro cuenta que la investigación implicó sucesivas etapas de trabajo como el diseño de un modelo de membrana, la formación del sistema, la estabilización del mismo; y por último el estudio de la interacción membrana-droga encapsulada. “En una etapa posterior lo que interesa conocer es cómo responde el modelo completo y correlacionar los resultados con los obtenidos con el modelo de membrana. Es un desafío porque computacionalmente requiere de muchos recursos”, dice la investigadora.

El polimerosoma, al estar hecho de polímeros permite una gran versatilidad en cuanto a los materiales, ya que son múltiples las formas en que puede prepararse o sintetizarse según criterios deseados como la permeabilidad o la elasticidad mecánica, por ejemplo. En este sentido, “las posibilidades de estudio son muchas, nuestro trabajo se centró en la encapsulación, una propiedad mecánica en particular” afirma Grillo y asegura que les interesaba especialmente cómo se veía afectada la estabilidad del sistema cuando se incluía el fármaco modelo. “Lo que hicimos fue colocar la droga hidrofóbica en la membrana y otra droga hidrofílica afuera, en el medio acuoso, queríamos ver cómo se modificaba el comportamiento del sistema ante la interacción de estos componentes. Observamos cómo variaba el perfil de presiones a lo largo de la membrana; lo que permitió entender el balance entre las fuerzas internas que ocurren dentro y determinar si la inclusión de la droga resultaba desestabilizadora”.

Juan Albano, es el médico de este equipo interdisciplinario. Afirma que estos estudios preliminares que se hacen desde el área teórica acortan mucho los plazos a la hora del desarrollo de nuevos nanocarriers con propiedades específicas; “además el mejoramiento continuo del software hace que la brecha entre las etapas teórica y experimental sean mucho más cortas. Por lo que la alimentación entre teoría, simulación y experimentación se ve enriquecida”.

“Los resultados nos permiten afirmar que la inclusión de la droga modelo no desestabiliza la membrana; por lo cual este tipo de sistemas que estudiamos serían aptos para ser usados en la administración de fármacos. Ahora continuamos trabajando en la incorporación del cálculo de presiones para sistemas esféricos en el programa de simulación , y de ese modo, poder calcular las presiones en el sistema completo”, concluye Ferraro.

Journal of Chemical Physics, 148, 214901 (2018)