Coloquio: Advanced microscopy techniques to enable the discovery of molecular mechanisms that regulate cell migration

- 12-06-2025 14:00 |

- Aula Federman

- Por Lis Tous -

El sueño llega, tarde o temprano, todos los días durante el transcurso de nuestra vida. Sin embargo, por qué dormimos es aún una pregunta crucial para la neurobiología. Ariel Haimovici, Enzo Tagliazucchi y Pablo Balenzuela construyen parámetros para distinguir los estados del sueño y la vigilia, y así, caracterizar modos globales del cerebro cuando dormimos y cuando estamos despiertos. Los investigadores pertenecen al Departamento de Física y al Instituto de Física de Buenos Aires (IFIBA), UBA-CONICET, y han publicado junto al Dr. Helmut Laufs de la Universidad de Kiel, Alemania, su trabajo en Scientific Reports.

"Sabemos que el cerebro humano no funciona como una máquina con un switch de encendido y apagado; más bien, se encuentra constantemente encendido. Los estados cerebrales se dan de manera global, es decir las neuronas pueden comunicarse entre ellas de manera local, pero a su vez dando origen a modos característicos de dinámica global. Por ejemplo, en la etapa más profunda del sueño la influencia de ciertos neurotransmisores transforman al cerebro en un sistema biestable, donde las neuronas alternan entre períodos con alta tasa de disparo y períodos de inactividad. Este comportamiento es cualitativamente más sencillo del que se observa durante la vigilia consciente”, aclara Enzo Tagliazucchi.

La originalidad del trabajo radica en la complejidad de la metodología aplicada, ya que integra el clásico encefalograma a las imágenes de resonancia magnética funcional -fMRI por sus siglas en inglés-. “Una vez superado este importante obstáculo técnico, el trabajo utiliza novedosos métodos de análisis multivariado para distinguir estados típicos de vigilia y de sueño en personas que están dentro del resonador”, dice Tagliazucchi. De esta forma, los investigadores pueden hipotetizar sobre comportamientos neuronales particulares conociendo -mediante estereotipos estadísticos- si la persona entró en una cierta etapa de sueño o no.

“Cuando realizamos estudios del cerebro utilizando fMRI suele aparecer un problema, ya que la persona puede pasar en el aparato aproximadamente una hora, se le suele pedir que cierre los ojos y a pesar de que hay ruido es una situación propensa al sueño. La forma de conocer si la persona está dormida y en qué etapa del sueño se encuentra es mediante el encefalograma, por eso necesitamos de las dos observaciones al mismo tiempo”, dice Tagliazucchi y enfatiza: “es muy importante poder diferenciar el estado de sueño del de vigilia particularmente cuando se estudian cuestiones clínicas y el uso de psicofármacos, ya que estos pueden introducir una variable de confusión estadística muy difícil de remover si no se hacen las mediciones adecuadas”.

A través de la resonancia se pueden reconocer los modos, o estados globales del cerebro. Mediante cambios en el flujo sanguíneo -mayor o menor presencia de oxígeno- se puede identificar qué regiones del cerebro tienen más actividad y cuáles trabajan simultáneamente, de manera coordinada. Con la información obtenida los científicos construyen mapas de correlaciones cerebrales, una representación de actividad neuronal simultánea.

Balenzuela reconoce que para realizar este tipo de experimentos debieron sortear un problema técnico complicado ya que necesitaban introducir un encefalograma dentro de un resonador nuclear, y por consiguiente, trabajar con la presencia de fuertes campos magnéticos cambiantes dentro del resonador. “Después medimos, debimos distinguir qué personas estaban dormidas y cuáles no para obtener así ejemplos de todos los estados posibles”, resume el investigador. Los estudios experimentales fueron realizados en el departamento de neurologia de la Universidad de Frankfurt, en Alemania, por el grupo de los Drs. Laufs y por el mismo Tagliazucchi.

Haimovici, por su parte, asegura que el resultado central del trabajo es el estudio de las fluctuaciones entre el acoplamiento de distintas regiones cerebrales mientras se conoce el estado de sueño, prescindiendo de la electroencefalografía. “Básicamente, computamos la manera en que el acoplamiento evoluciona en el tiempo y aplicamos técnicas de clustering para particionar distintos segmentos temporales de acuerdo a los patrones de acoplamiento. Esa división es un reflejo fiel de las fases de sueño que los sujetos transitan durante el experimento”.

Sueño y psicofármacos

“El problema de la pérdida de la vigilia en experimentos de resonancia magnética funcional es potencialmente desastroso en estudios clínicos”, dice Tagliazucchi y ejemplifica: “supongamos que nuestro objetivo es entender si una enfermedad como la esquizofrenia altera la actividad espontánea del cerebro; medimos una serie de pacientes y sujetos sanos y comparamos los resultados, encontrando diferencias llamativas. Si los pacientes psiquiátricos toman medicamentos -como neurolépticos o antipsicóticos-, es posible que estos incrementen la probabilidad de perder la vigilia y de que confundamos cambios en la actividad debido a una enfermedad con cambios en la actividad debido al sueño”.

Por otro lado, el investigador argumenta que existen en la actualidad inversiones millonarias en este tipo de estudios y “debido a nuestra línea de investigación han tenido que modificarse muchos de los protocolos experimentales para evitar este problema. Con este nuevo trabajo proporcionamos una herramienta para simplificar la estabilización de los niveles de sueño en los sujetos estudiados y por lo tanto atenuar este problema”.

El trabajo no solamente indica que deben tomarse precauciones para evitar la presencia de sueño en estudios con fMRI, sino que además proporciona una herramienta para “salvar” datos experimentales ya adquiridos en los cuales dichas precauciones no fueron tomadas. Tagliazucchi asegura que el análisis “puede ser aplicado retrospectivamente a grandes bases de datos clínicas que ya fueron adquiridas para identificar a aquellos sujetos que se mantienen despiertos e incluirlos en el análisis, así como para descartar a sujetos que evidentemente cayeron en un estado de sueño profundo. También podemos utilizar el método para estimar la probabilidad de que algunos resultados de la literatura atribuyan erróneamente diferencias causadas por el sueño a distintos trastornos neuropsiquiátricos”.

“El próximo paso en el que estamos trabajando es en la mejora de los algoritmos de clustering para tener una idea más precisa de la secuencia de eventos que llevan de la vigilia al sueño, con el objetivo de comprender con más profundidad el proceso de quedarse dormido. A partir de ahora, experimentos muy grandes, colaborativos, que involucran a muchos centros clínicos en el mundo pueden usar este algoritmo como un estándar”, concluye Balenzuela.

On wakefulness fluctuations as a source of BOLD functional connectivity dynamics, Scientific Reports, 2017. DOI:10.1038/s41598-017-06389-4

- Comunicación DF -

Durante el primer cuatrimestre de este año dos referentes internacionales en cosmología de precisión dictaron en el Departamento de Física un curso para estudiantes de licenciatura y doctorado. “Cora Dvorkin y Román Scoccimarro sumaron esfuerzos para combinar el trabajo de dar una asignatura en conjunto y aprovechar el tiempo al máximo. Fue una oportunidad muy especial, que no sucede todos los días, escuchar la clase de quienes escriben los libros sobre un tema”, dice Esteban Calzetta, coordinador del programa.

El curso abarcó los desarrollos más recientes en cosmología: radiación cósmica de fondo, oscilaciones acústicas de bariones, y la naturaleza de la materia y la energía oscura. Scoccimarro y Dvorkin son investigadores del Center for Cosmology and Particle Physics, New York University; y del Department of Physics, Harvard University, respectivamente. Ambos, graduados en el DF son líderes en el tema a nivel mundial.

“Hay tres vías para conocer la composición inicial del universo: por un lado la radiación cósmica de fondo; la nucleosíntesis que es la forma por la cual conocemos la cantidad de helio generado en el universo temprano; y una tercera forma es pesando galaxias, a través de lentes gravitatorias, viendo cómo la presencia de la galaxia distorsiona la imagen de objetos que son todavía más lejanos”, explica Calzetta, profesor del DF e investigador principal del IFIBA, UBA-CONICET.

“La idea que tenemos ahora es que el universo surge en algún momento, pasa por una etapa increíblemente caliente y densa y a partir de ahí se empieza a expandir. De esa etapa primordial quedan fluctuaciones que son de origen cuántico y a través de un proceso llamado pérdida de coherencia son las semillas de todas las estructuras que existen actualmente. Del mismo modo, esas fluctuaciones primordiales han dejado una marca en la distribución de estructuras a gran escala, que son las llamadas oscilaciones bariónicas", específica.

El investigador y coordinador del curso explica que la radiación cósmica de fondo está compuesta por ondas electromagnéticas, cuya longitud de onda se desplaza al rojo con la expansión del universo, de manera que cuando fueron emitidas correspondían a rayos x y ahora a microondas. El estudio de la radiación cósmica de fondo permite sacarle una foto al universo cuando tenía entre 300 y 500 mil años de edad -hoy tiene catorce mil millones-, por lo que es una galería de información preservada en el tiempo y la principal forma de acceder a ese universo temprano.

Por otro lado, el uso de las lentes gravitatorias permite conocer que el 30% de la materia total del universo está concentrado en galaxias y cúmulos, y sólo la sexta parte de ese porcentaje es materia bariónica, es decir, ordinaria. El investigador sintetiza los otros ejes del curso: “simplificando bastante decimos que la materia oscura es ese treinta por ciento que podemos ver a través de las lentes gravitatorias y la energía oscura es el setenta por ciento que no está concentrado en galaxias”.

Así, “la denominada materia oscura no se sabe exactamente qué es y cómo está distribuida en el universo. Podemos saber a partir del estudio de la radiación cósmica de fondo cuánta materia hay en el universo, porque cuando uno mira la distribución de las intensidades en el cielo se ven regularidades, como si uno estuviera mirando un dibujo hecho por la repetición de un patrón. Hay estudios que determinan qué tamaño tenía ese patrón al momento de la emisión de la radiación de fondo, pero el tamaño con el que lo vemos ahora depende no sólo del tamaño en su origen sino también de la densidad de materia en el universo desde entonces hasta acá, por eso se puede determinar con mucha precisión cuánta materia hay en el universo”.

La energía oscura se asocia con otro fenómeno relativamente nuevo en la historia del conocimiento, y es que el universo se expande y lo hace de manera acelerada. Según Calzetta hay teorías que hacen pensar a la energía oscura como explosiones, similares a la que originó el universo, pero a una tasa mucho menor. La energía oscura es inherentemente inestable, y eso es lo que impulsaría la expansión del universo en este momento. Contrariamente, la materia oscura que es estable y atrae gravitatoriamente, contribuye a la formación de galaxias.

“Tanto la materia como la energía oscura son hipótesis muy locas, sí. Pero, tienen la virtud de que permiten conectar varias observaciones que son completamente independientes entre sí, que usan distintos aparatos, que miran otras cosas. Cada uno de estos fenómenos pueden interpretarse de manera alternativa, el desafío es explicarlos todas a la vez”.

“El curso -al que asistieron muchos alumnos de licenciatura- fue diseñado para que los estudiantes lleguen a conocer los temas de frontera. Entender de qué se trata es tarea de varios años, pero fue una muy buena aproximación al conocimiento de estos temas por parte de dos expertos. Este tipo de estudios tiene una tradición muy fuerte en el Departamento de Física y estamos tratando de retomarla”, concluye Calzetta.

- Comunicación DF -

Mientras atraviesa el tramo final de su doctorado el físico Pablo Poggi publicó en la Revista Europhysics Letters (EPL) los resultados de su investigación: “¿Cómo se ve afectada la no Markovianidad cuando intentamos controlar el sistema externamente ?”, es la pregunta que dispara su trabajo. El artículo que escribió junto a Fernando Lombardo y Diego Wisniacki fue elegido por el editor como lo más recomendado de la edición (Editor’s Choice). Los investigadores pertenecen al Instituto de Física de Buenos Aires (IFIBA), dependiente de UBA-CONICET y al Departamento de Física - FCEyN - UBA.

“En las últimas décadas se ha generado una gran expectativa alrededor del potencial desarrollo de las tecnologías cuánticas. Sabemos que los sistemas microscópicos, que obedecen las leyes de la mecánica cuántica, podrían ser usados para realizar diversas tareas de una manera mucho más eficiente, si se los compara con sus análogos clásicos”, contextualiza Poggi.

Uno de los desafíos para lograr este objetivo es mantener a los sistemas cuánticos suficientemente aislados del entorno para que no pierdan coherencia. Es decir, la posibilidad de encontrarse en superposiciones de estados clásicos.

Uno de los desafíos para lograr este objetivo es mantener a los sistemas cuánticos suficientemente aislados del entorno para que no pierdan coherencia. Es decir, la posibilidad de encontrarse en superposiciones de estados clásicos.

La investigación busca conocer si es posible lograr un mayor grado de control sobre un sistema abierto que, irreversiblemente, pierde coherencia si se lo pone en contacto con un entorno especial. El investigador focaliza en aquellos contextos donde la coherencia del sistema puede recuperarse por un entorno particular conocido como no Markoviano. Son situaciones singulares, como las que suceden a muy bajas temperaturas por ejemplo, donde el desorden es menor.

“Si uno prepara el sistema cuántico con el que desea trabajar como una combinación coherente de estados clásicos, éste pierde la coherencia pero si se diseña un entorno especial, puede recuperarla”, aclara el investigador y explica que “sucede que por ser éste un entorno más ordenado posee memoria. Y, por lo tanto, la posibilidad de recuperar la coherencia momentáneamente”.

“Dentro de los resultados que obtuvimos, encontramos que cuando controlamos al sistema usando campos externos, es posible acentuar estos efectos no Markovianos, que se hacen más pronunciados en comparación a la evolución libre del sistema. Hallamos también que esta mejora se da cuando el sistema interactúa débilmente con el entorno, pero no tanto cuando la interacción es fuerte”, concluye Poggi.

Actualmente, los investigadores trabajan sobre las consecuencias específicas de diseñar un sistema de estas características, y si es posible lograr procesos controlados más eficientes.

Driving-induced amplification of non-Markovianity in open quantum systems evolution

DOI: https://doi.org/10.1209/0295-5075/118/20005

- Comunicación DF -

“Soy abuelo y viví una situación que tal vez le sucede a muchos, cuando llegó el momento de que mis nietos reciban las vacunas aparecieron ciertas dudas en la familia. Cotidianamente escuchamos discursos que aseguran la peligrosidad de las vacunas así que, en el marco de esta investigación, buscamos saber qué puede ocurrir si se abandona el consenso sobre la inmunización pública”, dice Claudio Dorso, Investigador principal del CONICET y profesor titular del Departamento de Física en Exactas, UBA.

Junto con Pablo Balenzuela, Investigador independiente de UBA-CONICET en el Instituto de Física de Buenos Aires (IFIBA) y Andrés Medus, ex becario doctoral del DF, los investigadores publicaron un trabajo en la revista Physica. En la investigación se explora, mediante simulaciones numéricas, posibles escenarios de brotes epidémicos por la influencia de personas que rechazan las vacunas.

Dorso señala que este es el primer trabajo de una línea de investigación a desarrollarse durante varios años: “La idea es poder ser cada vez más cuantitativos con los resultados. En nuestro trabajo mostramos como la hipótesis de formación de al menos un cluster, aunque minoritario, puede dar lugar al rebrote de enfermedades que considerábamos controladas”.

Los autores trabajan focalizados en la vacuna del sarampión y la forma de propagación que alcanza ese tipo de virus. Según la Organización Mundial de la Salud (OMS), esta enfermedad es una de las principales causas de muerte entre los niños pequeños, a pesar de que hay una vacuna segura y eficaz para prevenirla. En el año 2015 hubo más de 130 mil muertes por sarampión en todo el mundo, es decir, cerca de 367 por día o 15 por hora.

“Nuestra hipótesis es que vivimos con la sensación de estar a salvo de las epidemias, porque muchas enfermedades se han erradicado y ya no las padecemos. Por otro lado, nos encontramos con la idea de que es una decisión individual, de tipo privada y la verdad es que no, porque no vacunar a los niños tiene consecuencias para el resto de la humanidad”, afirma Balenzuela y caracteriza la situación como un problema de tipo complejo, donde el comportamiento colectivo no se puede predecir a partir de comportamientos individuales. “Eso hace que las interacciones sean no lineales y, por lo tanto, no se puede inducir el comportamiento del todo a partir del de las partes», resume el investigador.

El modelo

Los autores basan su trabajo en un modelo que permite simplificar un panorama de alta complejidad. La reducción de agentes -personas, grupos y Estado-, así como la polarización de opiniones y decisiones, permite evaluar si la hipótesis principal es relevante o no. Con el tiempo, los sistemas numéricos pueden profundizarse, sumar características, y así obtener escenarios en una multiplicidad de contextos.

“La OMS afirma que la inmunidad se alcanza cuando el 95 por ciento de la población está vacunado; se considera que quienes no recibieron inoculación son casos aislados, que no pueden provocar un rebrote de la enfermedad. En nuestro trabajo tomamos ese cinco por ciento restante para plantear esta hipótesis: cómo esta minoría podría provocar un rebrote de enfermedades virósicas altamente contagiosas -como el sarampión- si se mantiene unida”, sintetiza Dorso.

Balenzuela explica que la formulación del modelo se realiza sobre una red diversa, donde hay dos tipos de relaciones entre humanos: físicas y virtuales. Es decir, el modelo contempla vínculos de cercanía que permiten el contagio de la enfermedad, y relaciones a distancia que representan intercambio de información: “asume que hay sujetos anti-vacunas y que por afinidad cultural con otros, forman grupos y así transmiten opinión hacia conjuntos poblacionales más grandes”.

Según se desarrolla en el paper, el esquema teórico está basado en el modelo de Axelrod, donde la dinámica de interacción cultural se basa en dos premisas: por un lado, la probabilidad de interacción entre individuos es proporcional al número de atributos culturales que comparten; y por otro, la interacción aumenta la similitud cultural entre individuos.

“Hicimos un modelo de agentes, donde cada uno tiene algunas características, en este caso representado por un vector cultural. Una de esas particularidades es si está a favor de la vacunación o no; otras son la elección política, la situación económica, la religión, el club del que es hincha, etc. Es decir, el modelo asume que dos personas tienen más posibilidad de interactuar si son parecidas culturalmente entre sí, y además que a partir de la interacción las similitudes se refuercen. Como consecuencia, se van a formar clusters, grupos que están en contra de la vacunación y no permanecen aislados”, explica Balenzuela.

El trabajo contempla diferentes interacciones entre agentes: a nivel real la proximidad física les permite intercambiar opiniones, pero también generar contagios; por otro lado, las interacciones virtuales a través de medios y redes sociales sólo influencian las opiniones. Por último, se incluye el efecto de los grupos que rechazan las vacunas rotundamente y la acción del estado mediante campañas de vacunación, como fuerza opuesta.

Claudio O. Dorso, Andrés Medus, Pablo Balenzuela, "Vaccination and public trust: A model for the dissemination of vaccination behaviour with external intervention" Physica A 482 (2017) 433–443.

- Comunicación DF-

Desde que era estudiante Román Scoccimarro indagaba sobre temas de cosmología cuántica y del Universo temprano. Se licenció en el Departamento de Física y en 1992 partió a Chicago a hacer su doctorado. Ese mismo año el satélite COBE descubrió que había fluctuaciones en la radiación cósmica de fondo en distintas direcciones del universo. “Ese hecho hizo que el tema se vuelva mucho más interesante, por lo que decidí volcarme a algo que tenga contacto con las observaciones, no tan teórico”, reconoce el investigador.

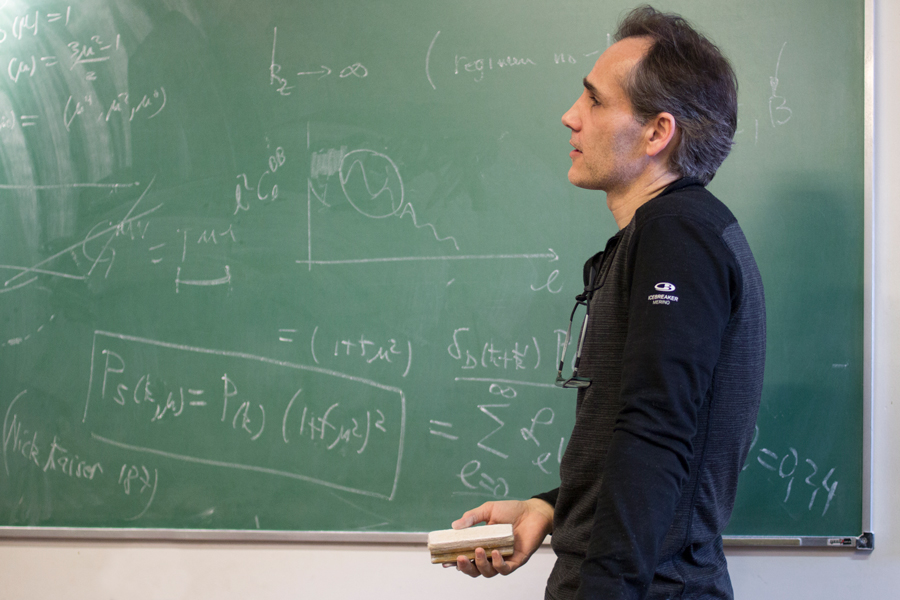

Junto a Cora Dvorkin disertan para la comunidad del DF sobre la actualidad de la cosmología en un curso de dos etapas dentro del Programa de Profesores Visitantes. La primera, sobre la formación de estructuras, finalizó la semana pasada y fue dictada por Scoccimarro como profesor invitado. La segunda - impartida por Dvorkin- será sobre la radiación cósmica de fondo: cómo se puede mapear la gravitación, la distribución de materia a partir de las lentes gravitatorias; nucleosíntesis y el origen de los elementos.

“Armamos este curso, que es intensivo, pero abarca varios temas. La mayoría de lo que expliqué en el pizarrón puede ser entendido por un alumno de licenciatura, pero en la plataforma virtual del curso hay información técnica para quienes están haciendo el doctorado”, resume Scoccimarro.

La distribución de galaxias - y las distintas maneras de observarlas- permite obtener información sobre el Universo temprano. Es decir, “cómo se formaron esos sistemas de estrellas, cuál es la ley de gravedad que acumuló a todas estas galaxias, si es consistente con la relatividad general o no”. El investigador explica en qué está trabajando hoy en la New York University: “Hay información hoy en día que nos permite saber cómo fue ese proceso inflacionario cuando el Universo tenía mucho menos de un segundo. Tratar de deducir toda esa física del Universo temprano que es la única manera de acceder a esas energías que son mucho más altas que las que podemos ver en el acelerador hoy en día. Como un detective vemos el final y tratamos de irnos atrás en el tiempo -miles de millones de años- para entender lo que vemos hoy”.

Sobre el presente inmediato del campo de conocimiento en el que trabaja, Scoccimarro afirma no hay grandes avances en cosmología pero que esperan que sí ocurran en próxima década: “en los últimos quince años no hemos visto cosas nuevas, desde 1998 que sabemos que el universo se acelera, no hemos tenido grandes avances. Pero, hay muchos experimentos nuevos que pueden encontrar cosas muy interesantes, estamos todos los investigadores pendientes de que se lleven a cabo para ver qué sale. Cuando encontremos esas respuestas vamos a tener nuevas preguntas, así es la ciencia”, dice.