Universo Startup 2

- 16-05-2025 20:56 |

- Cero+Infinito

* Por Luciana Bruno

En la página web de la Agencia Nacional de Promoción Científica y Tecnológica, organismo que otorga y administra fondos destinados, entre otros, a la investigación científica y tecnológica en Argentina, se lee lo siguiente:

“La evaluación de proyectos se caracteriza por la transparencia en sus acciones y por su procedimiento ético. El mérito de los proyectos es el único criterio de recomendación utilizado para la adjudicación de los subsidios y se determina a partir del análisis de la calidad y la pertinencia de los mismos” [1].

¿Quién podría no estar de acuerdo con estos principios rectores? Sin embargo, ¿es posible garantizar o al menos acercarse al ideal de objetividad en un proceso de evaluación real? El artículo que recomiendo, aparecido en la versión digital de la revista Physics Today el 1 de marzo de 2019 narra una experiencia piloto en ese sentido [2].

El caso desarrollado trata sobre la evaluación por pares que realiza el Instituto de Ciencia del Telescopio Espacial (STScI) para la asignación de tiempo de uso del Telescopio Espacial Hubble. El proceso de selección es altamente competitivo: cada año sólo una quinta parte de las más de mil propuestas presentadas sobreviven al riguroso sistema de revisión. El procedimiento de evaluación de los proyectos es muy similar al utilizado,

por ejemplo, por agencia argentina para el otorgamiento de subsidios para la investigación tales como los Proyectos de Investigación Científica y Tecnológica. El STScl invita a unos 150 astrónomos de la comunidad internacional a revisar las aproximadamente 1100 a 1200 propuestas y hacer recomendaciones a la dirección del Instituto del telescopio espacial. En una primera ronda de clasificación, los pares revisores, trabajan de forma remota y asignan calificaciones a las distintas propuestas. Luego, el personal de Instituto genera una lista de los proyectos altamente calificados que son discutidos por paneles de ocho a diez miembros que se reúnen en persona y determinan las propuestas ganadoras.

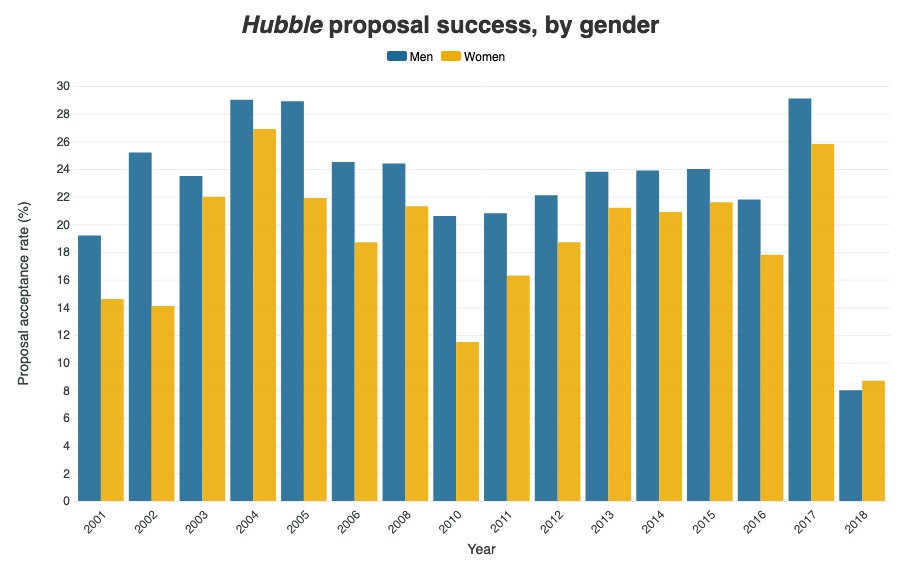

El artículo cuenta que Neill Reid, director asociado del STScI decidió examinar los resultados de las evaluaciones entre 2001 y 2012 y descubrió que las tasas de éxito de las propuestas lideradas por investigadoras mujeres -19%, en promedio- habían sido peores que las tasas de éxito de sus contrapartes masculinas -23%-. Aunque esta diferencia parecía menor, el desequilibrio fue sistemático, revelando un patrón de desventaja mediada por el género.

Frente a estos resultados, el Instituto de Ciencia del Telescopio Espacial decidió tomar cartas en el asunto y analizar el proceso de evaluación en detalle para dilucidar en qué momento del procedimiento se producía el sesgo (consciente o inconsciente) por género. Curiosamente, no se hallaron evidencias de desviación durante la calificación preliminar. Fue sólo en las reuniones de los paneles que el sesgo apareció y permitió identificar una razón potencial para ello: gran parte de la discusión sobre una propuesta dada se centraba en el historial del solicitante y sus colegas, en lugar de sobre la ciencia que él o ella estaba proponiendo.

Con estos resultados a la vista, se decidió hacer una prueba piloto que consistió en una evaluación doble-ciego en la última etapa de la selección: ni los evaluadores ni los evaluados sabían quién era la contraparte. Además, se incorporaron veedores en estas reuniones cuya función consistió en re-enfocar el debate de los evaluadores cuando la discusión se desviaba de la consideración del plan científico, como por ejemplo, intentar adivinar quién era el o la postulante.

Y los resultados fueron impresionantes: por primera vez, las propuestas lideradas por mujeres tuvieron una tasa de éxito mayor que las dirigidas por hombres. Los autores del trabajo sostienen que un proceso de revisión doble ciego tiene el potencial de nivelar el campo de juego, no sólo para las mujeres sino también para otros grupos marginados y desfavorecidos.

Sería interesante analizar si este tipo de sesgo ocurre en las distintas instancias de evaluación por las que transitamos durante nuestra carrera científica. Es por eso que les sugiero leer el artículo y pensar si podemos aprender algo de la experiencia del STScl.

*La autora es miembro de la Subcomisión de Género de la Asociación Física Argentina e Investigadora independiente CONICET, Instituto del Cálculo, Exactas, UBA.

1. https://www.argentina.gob.ar/ciencia/agencia/fondo-para-la-investigacion-cientifica-y-tecnologica-foncyt/evaluacion

2. https://physicstoday.scitation.org/do/10.1063/PT.6.3.20190301a/full/

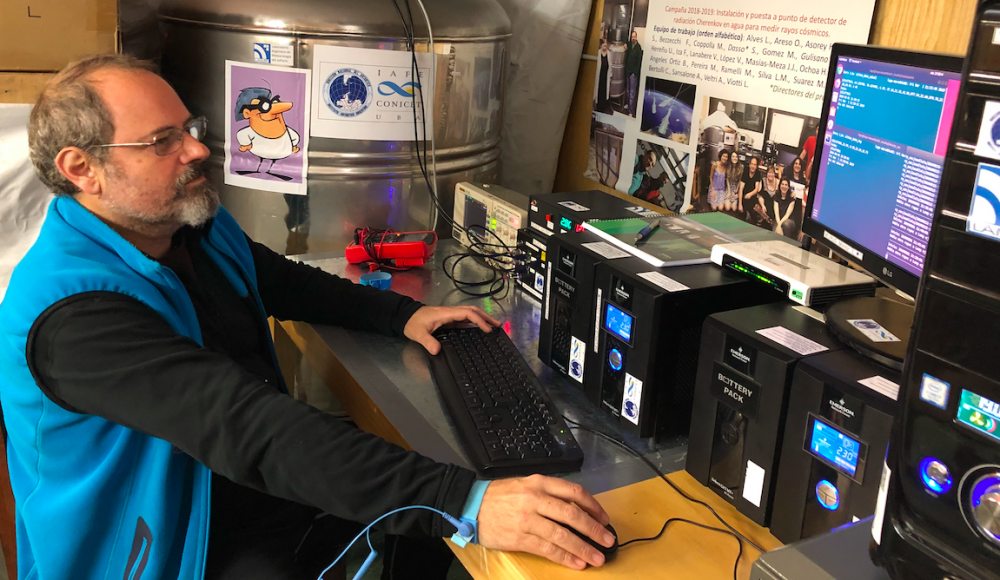

El físico Sergio Dasso lidera al grupo que acaba de poner en funcionamiento a Neurus, el primer detector de rayos cósmicos del país en suelo antártico. El nombre es un guiño a la mítica serie Superhijitus, por la forma de sombrero que sobresale en el detector, su componente principal:el soporte del fotomultiplicador que amplifica la energía de los fotones generados por las partículas que miden.

*Por Lis Tous

¿Por qué en la Antártida?

Básicamente, por la importancia de medir rayos cósmicos cerca del polo magnético. Los rayos cósmicos primarios que más nos interesan tienen carga eléctrica por lo que su trayectoria se desvía cuando ingresan al entorno espacial de la Tierra - debido al campo geomagnético-; se observan mayores flujos de partículas en altas latitudes y menos flujos en las regiones ecuatoriales. Durante las fulguraciones solares más violentas pueden generarse estructuras en la corona del Sol que funcionan como 'aceleradores' de partículas. Así, aparecen 'jets' de partículas cósmicas que pueden penetrar el ambiente espacial terrestre y llegar a regiones cercanas a los polos en la superficie de la Tierra. Estas partículas no pueden ser observadas con un detector en Buenos Aires o en Malargüe, pero sí pueden ser cerca de los polos.La comunidad conoce muy bien estas ventajas desde hace tiempo, y existen diversos tipos de detectores de rayos cósmicos en diferentes bases antárticas de otros países. Así, la Antártida es un lugar ideal para poder observar partículas solares.

¿Qué tipo de partículas “caza” Neurus?

Neurus permite detectar partículas secundarias con carga eléctrica, principalmente muones, electrones o partículas gammas por creación de pares que generan electrones y positrones de gran energía. Podemos discriminar y medir con gran exactitud cuánta es la energía depositada por la partícula cuando pasa a través del detector. El rango de la energía depositada que puede discriminar el detector va desde unos pocos MeVs (megaelectronvoltios) hasta unos pocos GeVs (gigaelectronvoltios).

Los rayos cósmicos que ingresan desde el exterior de la Tierra se denominan primarios. Cuando estas partículas se acercan a la superficie terrestre, se encuentran con la atmósfera y se desarrollan reacciones nucleares que llamamos lluvias o cascadas. Durante estos procesos, cada rayo cósmico primario genera una gran cantidad de rayos cósmicos secundarios. Nuestros detectores miden los rayos cósmicos secundarios, que son los que logran llegara la superficie terrestre.

¿En qué se diferencia este detector con otros como el Observatorio Pierre Auger?

Nuestro detector se enmarca en el Latin American Giant Observatory (LAGO), ahora que instalamos nuestro detector en la base Marambio, la colaboración tiene nodos desde México hasta la Antártida. Los detectores de esta red son versiones adaptadas más simples que los de superficie del Observatorio Pierre Auger.

El Pierre Auger está enfocado principalmente en los rayos cósmicos de mayor energía y por eso se requiere de un gran arreglo de detectores de superficie para hacerlo, si se tiene en cuenta que la extensión de la lluvia de secundarios está relacionada con la energía del rayo cósmico primario. Por esto también Auger tiene detectores de fluorescencia.

En nuestro caso, el interés que tenemos se enfoca en energías menores y en observaciones estadísticas como variabilidad de flujo y no en la observación de partículas individuales. Si bien por el momento no consideramos instalar detectores de fluorescencia en la Antártida, sí planeamos en el mediano plazo complementarlo con otros que permitan ampliar la validez de las mediciones.

¿Cómo van a publicar los datos generados?

En el mediano plazo, nuestra idea es que los datos estén disponibles en tiempo real. Esta decisión se basa en que recientemente se está implementando un sistema de provisión de datos de Meteorología del Espacio para la aeronáutica civil a nivel mundial. De hecho nuestro grupo participó en auditorías desde la Organización Meteorológica Mundial (OMM), auditando al centro de 'Space Weather' de NOAA y a un consorcio europeo llamado PECASUS (Pan-European Consortium for Aviation Space weather User Services). Estos centros, junto con varios centros de otros países se propusieron en el ámbito de la Organización de Aviación Civil Internacional (OACI) para proveer datos y pronósticos similares a los de la meteorología tradicional, pero en este caso vinculados con la Meteorología del Espacio.

El flujo de rayos cósmicos, al ser trazadores de las condiciones del espacio, son una parte importante dentro del conjunto de datos que se ofrecen en este campo. Y nuestro grupo así aportaría desde Argentina a caracterizar estas condiciones espaciales. Así, luego de un período de prueba de nuestros datos, cuando se los publique en tiempo real, se realizará un aporte regional a la caracterización de las condiciones espaciales en forma operativa.

¿Cómo es hacer ciencia en el continente blanco?

En cuanto a lo personal, el continente es tan diferente y maravilloso que cada día tuve un deslumbramiento diferente. Por ejemplo es muy impresionante ver los diferentes matices que tiene el mar de Weddell con sus impresionantes témpanos flotando. Por otro lado, allí el dinero no existe y este aspecto también implica un cambio muy interesante en el modo de vivir. El ambiente en la base es muy cordial y uno va conociendo a todas las personas, manteniendo un balance profesional y personal que muchas veces genera vínculos personales que trascienden las campañas.

En cuanto a lo hostil del clima el desafío es extremo, la planificación del trabajo depende fuertemente de las condiciones de cada día, ya que se deben evaluar muy bien como las tareas en función de los vientos, la intensidad de la nieve, la temperatura. Por otro lado, la planificación debe ser impecable, ya que aquí no existen lugares donde comprar repuestos o componentes, por lo que completamente todo debe ser exhaustivamente planificado y considerado antes de realizar la campaña.

| Participaron de la última campaña donde se montó el laboratorio de Space Weather y el detector en la base Marambio:Sergio Dasso, investigador principal en el IAFE/UBA-CONICET y profesor en DCAO/DF-FCEN-UBA; Adriana Gulisano, investigadora del IAA/DNA y JTP del DF; Matías Pereira y Omar Areso, ambos pertenecientes al personal de apoyo del CONICET en el IAFE. |

*Por Esteban Calzetta

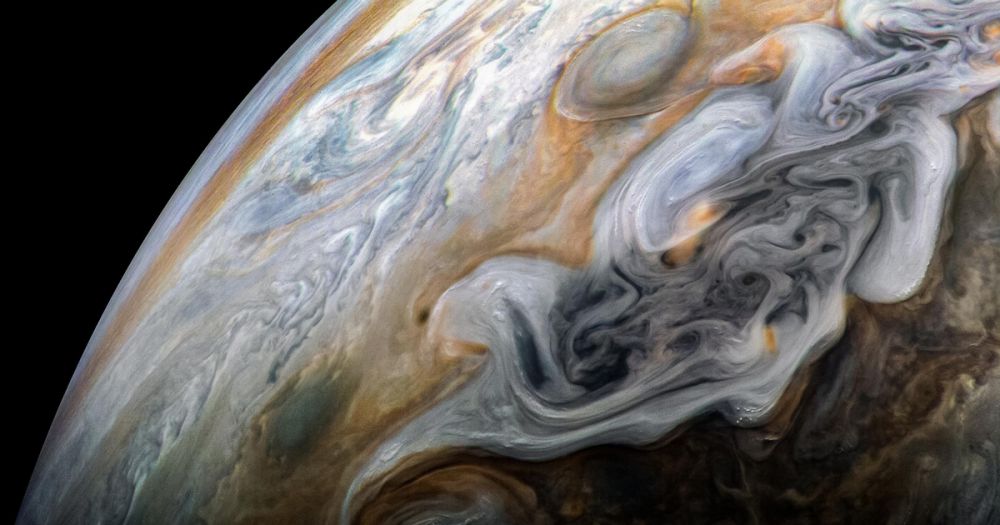

La turbulencia en fluidos es uno de los objetos de estudio más antiguos de la física. Concierne el movimiento irregular, por ejemplo, del agua de un arroyo, cuando el caudal supera cierto valor límite dado por la viscosidad del fluido y las dimensiones del cauce. La turbulencia aparece en todo tipo de sistemas, desde una canilla en nuestro hogar hasta el plasma que circunda un agujero negro.

Esta imagen de los fenómenos turbulentos fue descubierta no una sino tres veces, simultáneamente, por Andrei Kolmogorov, Werner Heisenberg y Carl von Weizsäcker, y Lars Onsager. Elporqué cada uno de estos gigantes trabajaba ignorando el progreso de los otros tiene algo que ver con la geografía -Kolmogorov estabaen la Unión Soviética, Onsager en Yale, y Heisenberg y von Weizsäcker en una granja en Inglaterra-; y mucho que ver con el calendario: los trabajos de los que estamos hablando se desarrollaron entre 1941 y 1945.

Esta imagen de los fenómenos turbulentos fue descubierta no una sino tres veces, simultáneamente, por Andrei Kolmogorov, Werner Heisenberg y Carl von Weizsäcker, y Lars Onsager. Elporqué cada uno de estos gigantes trabajaba ignorando el progreso de los otros tiene algo que ver con la geografía -Kolmogorov estabaen la Unión Soviética, Onsager en Yale, y Heisenberg y von Weizsäcker en una granja en Inglaterra-; y mucho que ver con el calendario: los trabajos de los que estamos hablando se desarrollaron entre 1941 y 1945.La formulación de Onsager era la más formal y matemática, y prácticamente cayó en el olvido. Onsager se la comunicó en una carta al principal experto en turbulencia de la época, Theodore von Karman, pero éste simplemente no entendió de qué le estaba hablando. Cuando finalmente Onsager publicó sus ideas, algunos años más tarde[2], la teoría de Kolmogorov (K41, por la fecha de la publicación original) ya era paradigmática.

Pero la teoría de Onsager contenía una predicción notable. En un fluido como el agua, hay disipación porque el fluido tiene viscosidad. Pero, ¿que pasaría si uno se imagina una secuencia de fluidos, cada vez menos viscosos? La predicción de Onsager es que la disipación no desaparece, ni siquiera en el límite en que la viscosidad se hace cero -o, en jerga, el “número de Reynolds” tiende a infinito-. El acoplamiento no lineal entre remolinos produce una “viscosidad efectiva” que reemplaza a la “viscosidad molecular”.

La búsqueda por una confirmación o refutación de la hipótesis de Onsager mantuvo a la teoría con vida, en este sentido el review de Eyink y Sreenivasan [3] contribuyó a hacerla más conocida y accesible; y en los últimos años una serie de nuevos resultados parece darle definitivamente la razón a Onsager [4]. El año pasado, un tour de force de Eyink y Drivas [5] finalmente tomó a la teoría de Onsager no como una curiosidad, sino como punto de partida para explorar problemas que no tienen una formulación clara dentro de la teoría K41.

La teoría de la turbulencia sigue siendo una verdadera caja de sorpresas.

Referencias

[1] U. Frisch, Turbulence: the legacy of A. N. Kolmogorov, Cambridge University Press (1995).

[2] L. Onsager, Statistical Hydrodynamics, Nuovo CimentoSuppl. 6, 279 (1949).

[3] G. L. Eyink, K. R. Sreenivasan, Onsager and the theory of hydrodynamic turbulence (Reviews of Modern Physics 78, 87 (2006) .

[4] Philip Isett, A Proof of Onsager's Conjecture, arXiv:1608.08301; Tristan Buckmaster, Camillo De Lellis, László Székelyhidi Jr. y Vlad Vicol, Onsager's conjecture for admissible weak solutions, arXiv:1701.08679.

[5] Gregory L. Eyink and Theodore D. Drivas, Cascades and Dissipative Anomalies in Compressible Fluid Turbulence, Phys. Rev. X 8, 011022 (2018); Cascades and Dissipative Anomalies in Relativistic Fluid Turbulence, Phys. Rev. X 8, 011023 (2018);Cascades and Dissipative Anomalies in Nearly Collisionless Plasma Turbulence, Phys. Rev. X 8, 041020 (2018).

El ICTP y la ICO premian hoy con el "Gallieno Denardo Award" al profesor del DF e investigador del IFIBA, Dr. Christian Schmiegelow por sus contribuciones a la óptica y la fotónica.

El premio, que entregan estas prestigiosas instituciones desde el año 2007 está destinado a jóvenes investigadores menores de 40 años por sus importantes contribuciones científicas y la promoción de la ciencia en países en desarrollo.

*Por Lis Tous

Lee filosofía desde los dieciséis años: era su entretenimiento durante el viaje en tren hacia la escuela. “No creo haber entendido la lógica de Hegel en ese momento, pero aprendí que podía pensar las cosas de otra manera”, dice Hernán Solari, investigador del IFIBA que acaba de publicar Una visión constructivista sobre la Mecánica de Newton en Foundations of Science. Mucho más tarde, en lo que él llama “un esfuerzo de pensamiento crítico dirigido hacia los fundamentos” se pregunta por los axiomas de Newton, de dónde vienen, cómo pueden pensarse, y cómo es posible generalizarlos en “el camino de la unidad de la razón que buscara Kant”.

¿Cómo empezaron a interesarte los fundamentos filosóficos de la teoría de Newton?

Mi preocupación, yo diría mi obsesión, siempre fue mirar qué hay detrás de las cosas. Cuando dictamos Física 1 o Mecánica enseñamos las leyes de Newton, podemos brindarle a los estudiantes algo de intuición sensible, experiencias que pueden hacer para aceptar esas proposiciones en el caso de la primera ley - el Principio de inercia - y de la tercera ley - Principio de acción y reacción -; pero para la segunda ley no hay intuición posible. El desafío es pensar de qué manera transmitirla. En un momento creí que la solución era leer al mismo Newton para conocer cómo él lo había pensado en su libro Los Principia, pero su texto está axiomatizado. Recién en la tercera edición, en el comentario del primer capítulo él discute, aunque de manera confusa, las intuiciones de las cuales partió su razonamiento; ahí aparecen sus ideas del espacio y el tiempo absolutos, pero yo diría que no termina de convencer. Entonces, nosotros nos preguntamos por los fundamentos que conducen a estas ideas, que por lo menos nos parezcan aceptables, las razones que hay detrás de las leyes. Ahí es cuando nos dimos cuenta de que lo que estaba operando era un principio de no arbitrariedad.

¿Cómo entienden a la arbitrariedad?

Estrictamente hablando, la arbitrariedad es la falta de razón. Me interesa hace muchos años la dialéctica entre lo objetivo y lo subjetivo, el conocimiento es ese diálogo. De alguna manera el sujeto está influyendo sobre lo que está conociendo, ocurre un proceso de ideación que “contamina” a lo real, aquello que está afuera. Entonces, cómo acceder a lo real cuando todo lo que tenemos está contaminado por el sujeto, que no es individual sino el sujeto de la cultura, el sujeto histórico. De alguna manera, aparece la idea de que hay que suprimir al sujeto, entrar en la categoría de lo intersubjetivo en términos de Hegel. Nuestro trabajo es básicamente ver hasta dónde podemos liberarnos de la arbitrariedad del sujeto y cuánto nos ofrecía esa opción para construir de nuevo las leyes de Newton.

Y en ese sentido, en el trabajo realizan una matematización del Principio de No Arbitrariedad, un concepto de Leibniz...

Hay mucho de Leibniz en nuestro trabajo. Por un lado el programa de Descartes y Leibniz de matematización de la filosofía natural, por el otro, cómo Leibniz utilizaba el principio de razón suficiente -en su correspondencia con Clark, por ejemplo- que traducido a su forma más corta dice: "Si no hay razón para ello, no debemos hacer diferencia".

Nosotros lo ampliamos a una forma frecuente en la argumentación matemática: si por necesidad de la exposición debo introducir elementos que no responden a la razón -arbitrariedades- los resultados que se adquieran por este proceso deben obtenerse de manera equivalente con cualquier elección arbitraria de esos elementos. Es decir, que debe haber una función que me lleva de uno a otro caso, y funciones que puedo combinar para viajar por el conjunto de las arbitrariedades. Esto resulta en la matematización del principio de Leibniz asociándole una estructura de grupo. El espacio de Leibniz cumple con el requisito que lleva su nombre, pero si a ese espacio le sumamos la presentación de Descartes en términos de sistema de referencia, debemos introducir arbitrariedades. Las llamadas propiedades del espacio como homogeneidad e isotropía son requerimientos de la razón para eliminar la arbitrariedad del espacio referencial, al que llamamos subjetivo, que en el niño es el propio yo, el sujeto, la referencia.

Entonces, la diferencias, no surgen de la empiria, las propiedades surgen como necesidad de supresión de la arbitrariedad, son condiciones impuestas por la razón a algo que acabo de inventar: el espacio subjetivo, el espacio práctico que usa Newton. Después de introducir el tiempo como la medida del cambio, podemos hablar del cambio en las posiciones relativas, es decir, la velocidad relativa que cumple el requisito de Leibniz e introducir la velocidad subjetiva por la identificación del observador que dice "yo no me muevo". La remoción de ésta arbitrariedad la realiza la transformación de Galileo, que así deja de ser empírica como se suele argumentar, sin explicar el cómo de esa conclusión, para pasar a ser un requisito de la razón.

Si la arbitrariedad es la falta de razón, la no arbitrariedad es la negación de la negación, es decir la razón que se alcanza atravesando su opuesto. Este principio de racionalidad aparece en muchas ocasiones sin que podamos dar cuenta de él más que intuitivamente. Cada vez que percibimos un trato dispar de quienes consideramos iguales nos quejamos de la arbitrariedad y de la injusticia. El imperativo categórico de Kant, "actúa de tal modo que la norma de tu conducta sea aplicable a todos y universalmente válida", podría resumirse en "se razonable" y desplegarse con NAP. La igualdad ante la ley que proclaman las constituciones de los estados republicanos, es otro ejemplo. Como lo es el Principio de Relatividad que parece venir de la nada, principio empírico dicen Poincaré y Einstein. ¿A qué observaciones y experimentos refieren? pregunto yo, olvidan mencionarlos. Poincaré indica que hay algo más, que no pensar así le resulta repugnante. ¿Repugnante? si, como nos repugna la injusticia por ejemplo. Lo que intuyen es el Principio de No Arbitrariedad.

Segun Husserl hay una diferencia entre intuición simple o natural e intuición filosófica. En la primera las cosas se nos aparecen como ciertas sin más y así las aceptamos, en la segunda ponemos un control racional, una reflexión sobre el propio proceso de construcción de la idea. De esta manera, por la consciencia de la ideación, empiezo a estar en condiciones de saber cómo son los aportes a eso que me resulta cierto o aceptable, ¿qué viene de lo observado? ¿cuánto puse de mis ideas previas y de mi razón en lo ideado? ¿cuál es su forma perfeccionada? Esta intuición filosófica no es lo más común en los físicos, predomina en nosotros lo que se ha dado en llamar "realismo metafísico". El realismo metafísico ignora el proceso de producción de las ideas y de esta forma saca al sujeto de la escena, se engaña pensando que es objetivo por el solo hecho de no tener consciencia del sujeto. El espacio que es una construcción de la mente es tan real como mi perro que envía señales sensoriales de todo tipo. No niego que sean ambos reales pero la naturaleza de su realidad no es la misma y confundirlas tarde o temprano tiene consecuencias.

¿Y cómo aparecen Jean Piaget y Rolando García en esta reconstrucción?

Las contribuciones de Piaget en referencia a estas ideas se refieren al espacio de Newton como “el espacio del niño”, que está en el centro de la escena. Es un espacio subjetivo pero esta subjetividad se puede reprimir, en el sentido que puede comunicarse a otros. La intersubjetividad habla de una estructura común en todos nosotros, entonces, si algo es objetivo deberá ser también intersubjetivo. Estas son cuestiones que se plantearon desde muchas disciplinas; Kant, por ejemplo, que era físico, hablaba desde la filosofía sobre los “a priori” del conocimiento y en esos textos discute el espacio, el tiempo. Como no puede dar cuenta de ellos dice que son intuición pura. Luego, Husserl desde la fenomenología y Piaget puntualmente sobre el espacio y el tiempo van a decir que son construcciones del ser. Esto es un antecedente que nos permite pensar las teorías físicas; y ese es el programa, no pensar “hacia adelante”, es decir todo lo que podemos hacer sabiendo mecánica, todos los aparatos que se puedan construir.

Una razón donde lo consecuente está implícito en los antecedentes, es el juicio analítico de Kant. En cambio, nosotros queremos ir “hacia atrás”, el juicio sintético, el juicio crítico. O, en términos de Piaget y García, buscamos hacer rebasamientos de lo particular hacia lo general.

¿Cuáles son puntualmente los elementos conceptuales que aportan Piaget y García desde su epistemología constructivista?

Piaget y García tienen un libro en común que se llama Psicogénesis e historia de la ciencia, es el único libro de Piaget que salió primero en castellano. En ese libro ellos tratan de argumentar que existe un paralelo entre la forma en que se desarrolla el conocimiento en las etapas de desarrollo del ser humano, de la misma manera en que progresa el conocimiento en la humanidad. Y, entonces, estudia la historia del álgebra, la historia de la física… Trabajan la idea de rebasamiento, aquello que conocemos por separado y que luego se contemplan en un universal, en algo que las contiene a todas como casos particulares. Por lo tanto, no es que lo nuevo reemplaza a lo viejo, sino que lo viejo queda contenido en lo nuevo y, a la vez, es el soporte de esta nueva mirada. Es la dialéctica entre lo universal y lo particular, que no pueden distinguirse claramente uno del otro. Entonces, el niño progresa -según Piaget- a partir de sucesivos rebasamientos, que podríamos pensarlos también como abstracciones. En algún momento se detiene, la persona encuentra el límite de su construcción. Trabajar en los rebasamientos de la física es ir al lado duro del asunto, y es en lo que nosotros nos divertimos.