Coloquio: La Astronomía en los tiempos de la IA

- 2025-08-21 14:00 |

- Aula Federman

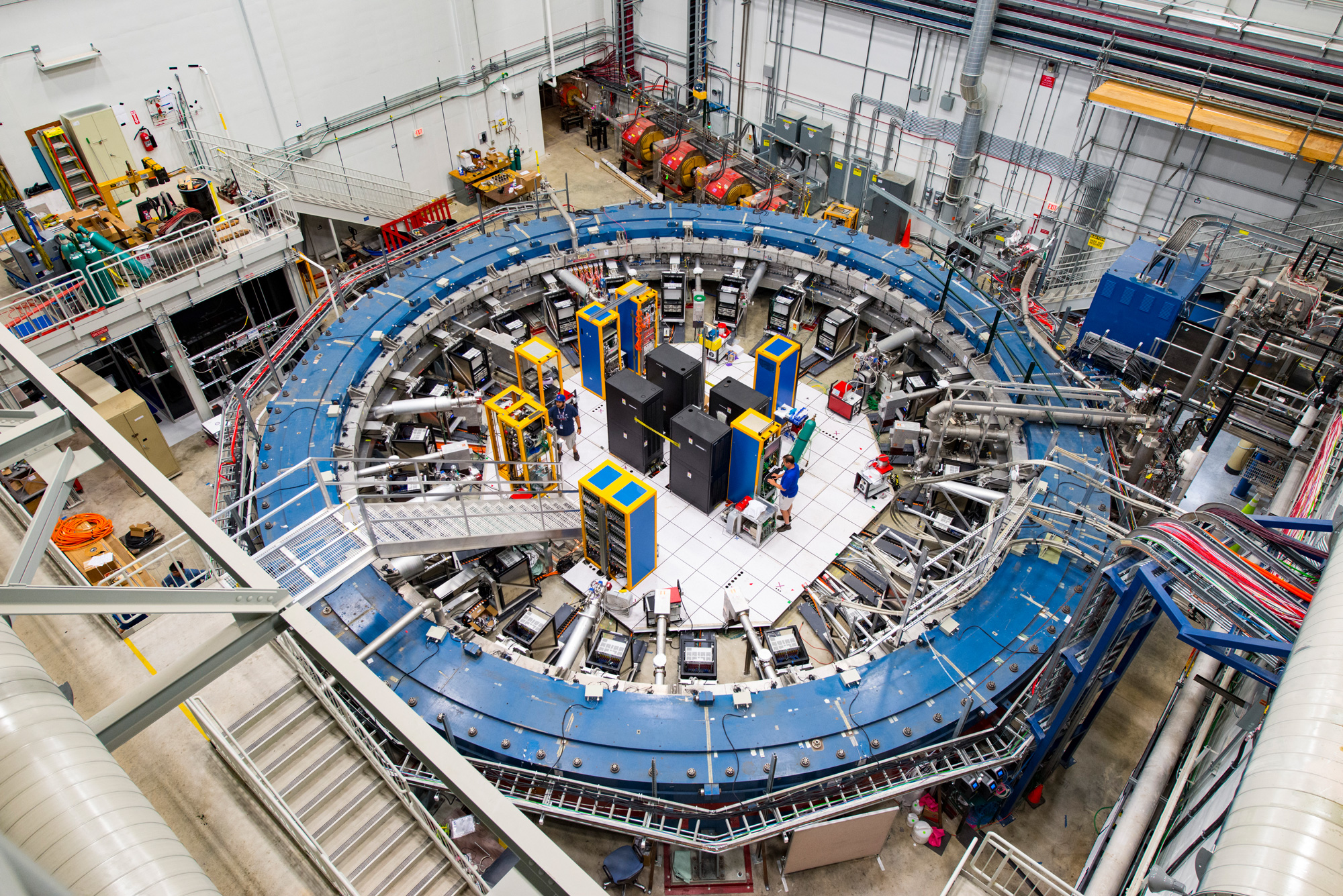

“Los muones han tambaleado más de lo esperado en un anillo magnetizado”, fue el anuncio que los físicos del Fermi National Accelerator Laboratory han hecho en estos días. Tres investigadores del DF explican el anuncio, los desafíos y dificultades que implica este acercamiento a lo que en la jerga se llama "nueva física", es decir, más allá de la frontera del Modelo Estándar.

*Por Ricardo Piegaia

La semana pasada, el experimento g-2 del Laboratorio Fermilab en EE.UU. anunció sus primeros resultados, que muestran una discrepancia entre la predicción teórica y el valor experimental del momento magnético anómalo del muón, una partícula elemental sin estructura interna, pariente del electrón sólo que algo más pesada.

Ahora bien, ¿qué es momento magnético anómalo y por qué importa su medición para el muón?, ¿cuán interesante es el resultado obtenido?, ¿por qué el experimento se llama g-2?. Veamos.

De Física 3 sabemos que una partícula de carga e y masa m, con impulso angular L, tiene asociado un momento dipolar magnético dado por μ=(e/2mc)L, donde c es la velocidad de la luz. En presencia de un campo magnético uniforme éste rota sobre sí mismo pues recibe un torque τ=μxB. La medición de la velocidad angular de esta rotación permite entonces determinar el valor de μ. Cuando se descubrió, en los albores de la cuántica, que las partículas poseían impulso angular intrínseco, se descontó que tendrían asimismo un momento magnético intrínseco dado por la ecuación clásica μ=(e/2mc)S, donde el spin S vale ħ/2 para el caso del electrón y el muón, siendo ħ la constante de Planck reducida. La naturaleza, como tantas veces, decidió dar una sorpresa y el valor experimental resultó ser el doble, o sea μ=g(e/2m)S donde g=2 es una corrección empírica. Más tarde, en 1930, Dirac propuso su famosa ecuación y logró mostrar que el factor g=2 surgía naturalmente al combinar la cuántica y la relatividad.

Pero la historia no quedó ahí. Hacia 1950 se descubrió experimentalmente que el momento magnético del electrón era "anómalo": g no era exactamente 2. La diferencia, g-2, que dio nombre al reciente experimento en Fermilab, era de 0.1%, pequeña pero no nula.

Para esa misma época se desarrolló la teoría cuántica de campos (QFT), en la que se basa hoy en día el llamado Modelo Estándar (SM), la exitosísima teoría que describe la materia y las interacciones fundamentales en términos de 17 partículas elementales. Una de las predicciones de QFT es que el vacío, lejos de estar "vacío", rebosa de fluctuaciones en que pares de partículas del SM se crean y prontamente se aniquilan. Para indicar su existencia efímera, se las denominó partículas virtuales.

Una partícula aislada, como un electrón o un muón, se ve afectada por este mar de partículas virtuales, causando pequeñas pero calculables desviaciones en el valor del dipolo magnético predicho por la ecuación de Dirac. El Modelo Estándar permite calcular cómo se afecta el g-2 de una dada partícula elemental, p.ej el electrón, por encontrarse rodeada de las fluctuaciones virtuales de las 17 partículas que componen el Modelo Estándar. La belleza de esto es que el electrón interactúa también con las fluctuaciones virtuales de partículas que aún no hayamos descubierto, si éstas existieran. De ahí la importancia de medir el momento magnético anómalo. Una desviación experimental respecto a las predicciones del SM sería evidencia de "nueva física".

La medición más reciente para el electrón es de 2008, mientras que la predicción teórica se refina año a año. La situación hoy en día se resume comparando los factores de anomalía ae=(g-2)/2, que corresponden a la desviación relativa respecto a la predicción de la ecuación de Dirac:

ae(exp) = 0.00115965218073 (28)

ae(teo) = 0.00115965218204 (72)

Es remarcable la semejanza entre ambos valores. De hecho, se trata del resultado con mayor nivel de acuerdo entre teoría y experimento en todas las ciencias naturales. Un triunfo para QFT y su danza de partículas virtuales en el vacío.

Las cifras entre paréntesis indican la incerteza en los últimos dos dígitos. En el caso experimental esta proviene de la precisión de los instrumentos de medición. Es interesante que la teoría también presente una incerteza, y de hecho mayor que la experimental. La razón es que la predicción teórica depende a su vez de magnitudes experimentales como la carga y masa del electrón y el muón, la constante de Planck, o la velocidad de la luz.

Ahora, ¿por qué el g-2 del muón es más interesante? La teoría cuántica de campos predice que el efecto de una partícula virtual X en el g-2 del electrón o del muón depende del cociente me/mX o mμ/mX, respectivamente. Como el electrón es muy liviano (1/2000 la masa del protón), esta influencia es muy pequeña. Y aquí es donde hace su entrada el muón. Con 200 veces más masa que el electrón, es mucho más sensible a las fluctuaciones de vacío de las partículas más pesadas, tanto las conocidas como las no descubiertas aún. La ventana a nueva física que abre el g-2 del muón es mucho más amplia.

¿Y cuál es la situación actual? Para darse cuenta de las dificultades involucradas, mencionemos que el valor teórico surge de un comité de 170 expertos que arribó a un resultado consensuado basado en tres años de talleres y cálculos utilizando el Modelo Estándar. Y aún así no es total el acuerdo en la comunidad. Desde el punto de vista experimental, toma la palabra el resultado de esta semana en Fermilab:

aμ(exp)=0.00116592061(41)

aμ(teo) =0.00116591810(43)

¿Son consistentes estos resultados o hay discrepancia? ¿La diferencia se puede explicar como una fluctuación? Ilustremos esto comparando con el experimento de tirar 100 veces una moneda para averiguar si está cargada. Si salen 50 caras, no hay evidencia de moneda cargada. Si salen 58 caras, todos estaremos de acuerdo que puede ser la fluctuación estadística de una moneda no cargada. Esa es la situación con el g-2 del electrón. Ahora, ¿cuántas caras deberían salir para que concluyamos que la moneda está cargada (o que hay nueva física, en el caso de Fermilab)? Los físicos requerimos lo que se denomina una discrepancia de 5 sigmas, que en el caso de la moneda correspondería a obtener 75 caras. Bien, el resultado del muón corresponde a 71 caras. Casi casi. Teniendo en cuentas que hasta ahora solo han utilizado 5% de los datos totales que colectarán, hay buenas perspectivas que podrán dar una respuesta concluyente a la pregunta "¿hemos visto nueva física?".

No deja de impresionarme que midiendo a qué velocidad rota un muón en un campo magnético uniforme se pueda descubrir nueva física antes que haya evidencia de ella en los experimentos diseñados a tal fin en los grandes colisionadores. Qué linda que es la física.

*Por Rodolfo Sassot

La comparación entre teoría y experimento al extraordinario nivel de precisión del experimento Muon g-2 [1], que es del orden de media parte por millón, requiere que en el cálculo teórico se incluyan las contribuciones de los efectos de la polarización del vacío. Estos efectos son predichos por las teorías cuánticas de campos con las cuales describimos las interacciones en el Modelo Estándar y se pueden pensar por analogía con la polarización de un medio material.

De la misma manera que la presencia de una carga eléctrica puede alterar la distribución de cargas presentes en el medio, y dicha redistribución modifica la forma en que se percibe la carga y sus interacciones asociadas, a nivel ultra-microscópico las partículas -en nuestro caso el muón- interactúan con las fluctuaciones del vacío en pares partícula-antipartícula.

En el caso de las interacciones electromagnéticas y débiles los efectos asociados a la polarización del vacío se pueden calcular de primeros principios en forma perturbativa, y el error introducido por el truncamiento de la serie perturbativa es despreciable comparado con el error experimental para el experimento Muon g-2. En cambio, para las interacciones fuertes, no es posible hacer un cálculo perturbativo ya que el mismo no converge para el rango de energías involucradas en este experimento, y es necesario estimar la contribución de otra manera.

La manera más tradicional de hacerlo es analizar otros procesos donde intervienen estas correcciones y que ya han sido medidos, como la producción de partículas en la aniquilación electrón-positrón o los decaimientos del mesón tau, y aislarlas a partir de consideraciones generales, denominadas genéricamente métodos dispersivos. Esto, por supuesto no está exento de ambigüedades; no sólo las incertezas experimentales de dichas mediciones, sino otras de tipo más metodológico. De hecho, son las principal fuente de error en las predicción teórica del momento magnético del muón. Con el objeto de tener en cuenta los resultados de las distintas metodologías y mediciones, y combinarlos en una única predicción teórica, desde 2017 más de un centenar de especialistas conformaron un grupo de trabajo denominado "Muon g−2 Theory Initiative" [2]. El experimento Muon g-2 utiliza la predicción teórica de este grupo de trabajo y a partir de ella llega a la conclusión de que hay una discrepancia de 4.2 desviaciones estándar entre teoría y experimento.

Alternativamente, las correcciones asociadas a las interacciones fuertes pueden ser estimadas usando técnicas de teoría de campos en el retículo (lattice), que es una acercamiento a los problemas que no admiten un tratamiento perturbativo muy promisorio y que ha venido evolucionando rápidamente en los últimos años [2,3]. Sin embargo, típicamente las predicciones que realiza tienen mayores incertezas que las de los métodos dispersivos y difieren entre sí significativamente dependiendo de las aproximaciones que realiza cada grupo. Dentro de la gran variabilidad de estos cálculos es que se pueden encontrar estimaciones que acuerdan alternativamente con las predicciones de los métodos dispersivos, como con el resultado experimental, no dejando espacio para contribuciones de potencial nueva física [3].

[1] B. Abi et al., arXiv:2104.03281

[2] T. Aoyama et al., Phys. Rept. 887 (2020) 1-166, arXiv:2006.04822.

[3] Sz. Borsanyi1, et al., Nature, https://doi.org/10.1038/s41586-021-03418-1

*Por Daniel López - Fogliani

Fermilab ha anunciado el 7 de Abril de 2021 una discrepancia de más de cuatro sigmas para el momento magnético anómalo del muón con respecto a la predicción del modelo estándar de las partículas elementales (SM). Un deseado indicio de física más allá del modelo estándar. Si bien cierta cautela siempre es necesaria, y todavía hay cierta controversia entorno a los cálculos realizados en el SM, sobre todo desde la comunidad que trabaja en ''lattice QCD'', hay motivos para el entusiasmo. Los autores del artículo Leading hadronic contribution to the muon magnetic moment from lattice QCD, donde obtienen un resultado en él cuál desaparece la discrepancia entre el SM y los experimentos, han finalmente publicado sus resultados en la revista Nature más de un año después de la aparición en arXiv y justo cuando se daba el anuncio de Fermilab. Pero, por otro lado Consistency of hadronic vacuum polarization between lattice QCD and the R-ratio fue publicado hace tiempo en PRD y mantiene la discrepancia entre resultado experimental y la predicción del SM. La controversia entre distintos resultados que utilizan "lattice QCD" continua.

El SM es el modelo más simple que describe la física de las partículas fundamentales, con excepción de la física de neutrinos y la materia oscura que requieren extender el modelo. Podemos decir que el muón es un hermano del electrón, que posee mayor masa. Es pertinente observar que recién en el año 2012 se terminó de confirmar experimentalmente la existencia de todas las partículas predichas por el SM, con el afamado descubrimiento del Bosón de Higgs.

Entre las propuestas para explicar la física más allá del modelo estándar se encuentran las extensiones supersimétricas del mismo. Desde el punto de vista teórico son capaces de describir toda la fenomenología conocida, dando al mismo tiempo un entendimiento profundo de la física hasta la escala de Planck. Escala que se encuentra lejos de poder ser escudriñada por experimentos, y a la cuál el propio espacio-tiempo sufre la indeterminación cuántica.

Modelos supersimétricos muy simples como el μνSSM son capaces de dar cuenta de la física de neutrinos, brindar candidatos a materia oscura en forma natural, y reproducir el reciente resultado que se aleja de las predicciones del SM. Además, señales de nueva física que pueden ser observadas en un futuro cercano en experimentos como el LHC son predichas por este tipo de modelos. Trabajando codo a codo experimentales y fenomenólogos lentamente se van desvelando los misterios de la naturaleza, y nuevos resultados experimentales pueden estar por sorprendernos en el futuro cercano.

"Measurement of the Positive Muon Anomalous Magnetic Moment to 0.46 ppm", Phys. Rev. Lett.126.141801 (2021); DOI: 10.1103/PhysRevLett.126.141801

*Por Federico Kukso

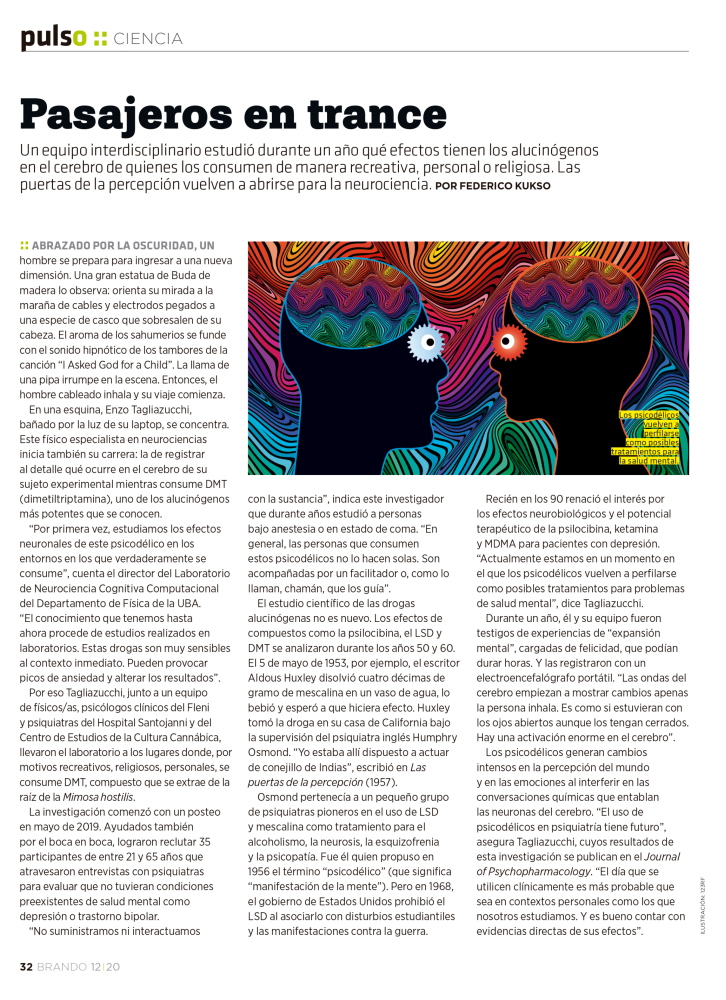

Un equipo transdisciplinario estudió durante un año qué efectos tienen los alucinógenos en el cerebro de quienes los consumen de manera recreativa, personal o religiosa.

Las puertas de la percepción vuelven a abrirse para la neurociencia.

*Por Lis Tous

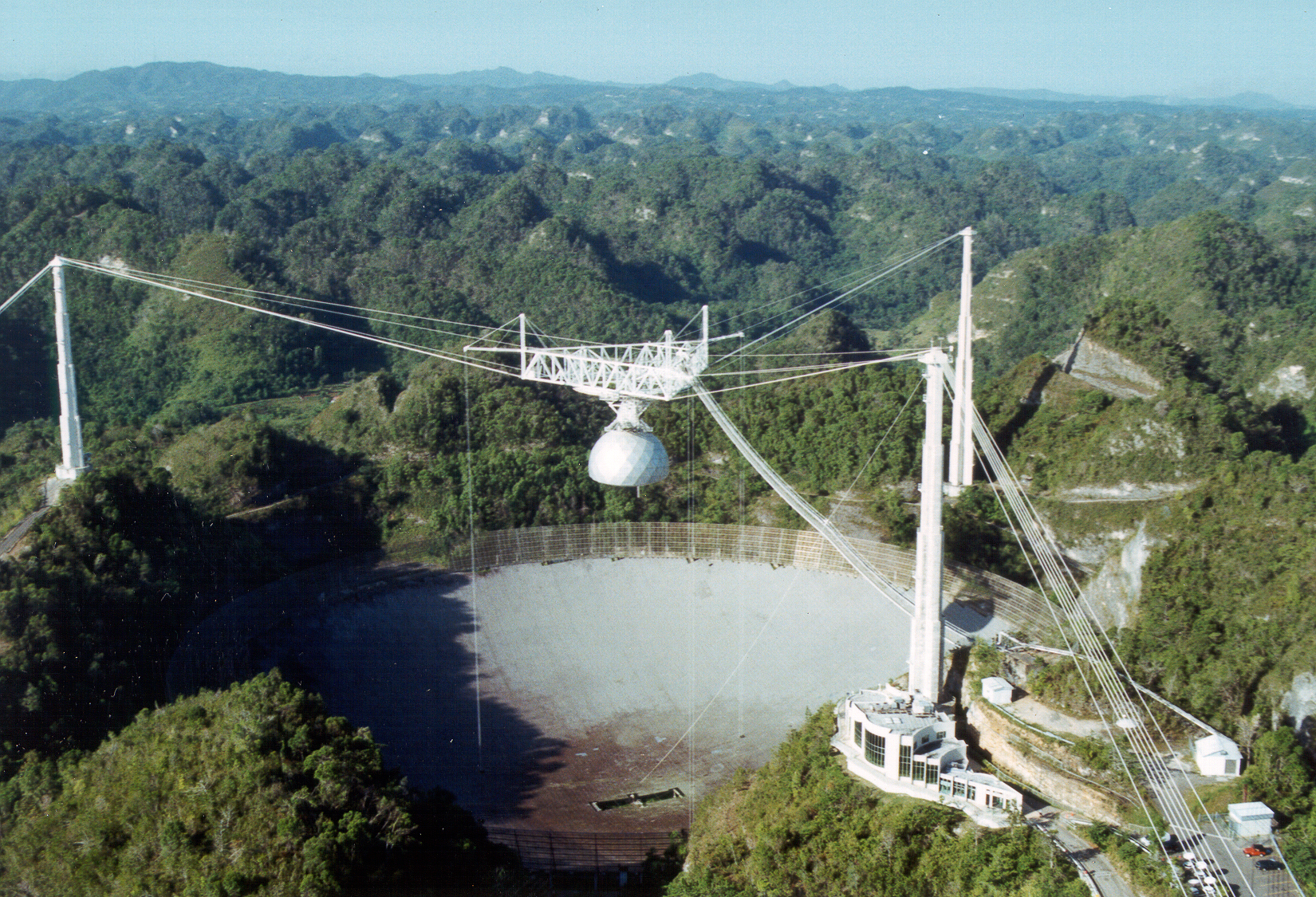

El 1 de diciembre pasado colapsó el radiotelescopio ubicado en Arecibo, al norte de Puerto Rico. Fue un gigante que ayudó, durante 45 años, a descubrir fenómenos astronómicos nunca antes imaginados. Desfinanciado y con problemas de mantenimiento, su estructura dijo basta. El investigador argentino, Félix Mirabel, quién trabajó en el centro de Arecibo, reflexiona sobre el valor de este proyecto que hizo historia en la ciencia mundial.

El legendario radiotelescopio de Arecibo ha colapsado luego de sufrir varios deterioros en su estructura. Ubicado en el norte de la isla de Puerto Rico, en los últimos años había soportado tres huracanes, terremotos de magnitud y una desfinanciación constante. Desde agosto se registraron daños importantes, por lo que los ingenieros que debían evaluar el deterioro habían recomendado su desmantelamiento. El 1ro. de diciembre último, mientras se monitoreaba a través de cámaras el estado de los cables, vimos derrumbarse la plataforma de los receptores del radiotelescopio sobre la antena. Novecientas toneladas desplomadas en segundos marcaron el fin de este mensajero del universo.

El legendario radiotelescopio de Arecibo ha colapsado luego de sufrir varios deterioros en su estructura. Ubicado en el norte de la isla de Puerto Rico, en los últimos años había soportado tres huracanes, terremotos de magnitud y una desfinanciación constante. Desde agosto se registraron daños importantes, por lo que los ingenieros que debían evaluar el deterioro habían recomendado su desmantelamiento. El 1ro. de diciembre último, mientras se monitoreaba a través de cámaras el estado de los cables, vimos derrumbarse la plataforma de los receptores del radiotelescopio sobre la antena. Novecientas toneladas desplomadas en segundos marcaron el fin de este mensajero del universo.

Durante medio siglo, el que fuera el detector de ondas de radiofrecuencia más grande del mundo permitió observar y estudiar los púlsares, ese fenómeno que se origina en las estrellas de neutrones, que es una forma particular de morir que tienen las estrellas. Pero no solo eso: el Observatorio de Arecibo abrió las puertas hacia el universo profundo: permitió probar indirectamente la existencia de ondas gravitacionales. En 1974 permitió el descubrimiento del primer sistema binario de púlsares, hallazgo que dio lugar al premio Nobel de Física de 1993.

En agosto de 1989, el radar de Arecibo hizo posible construir la imagen de un asteroide por primera vez en la historia: el Castalia. A partir de las observaciones realizadas en Arecibo también se detectaron los primeros planetas fuera de nuestro sistema solar y se determinó el período de rotación de Mercurio. Funcionando como radar permitió explorar la atmósfera superior terrestre así como desentrañar la superficie de Venus.

Como tantos astrónomos alrededor del mundo, el argentino Félix Mirabel trabajó en el Observatorio de Arecibo. Durante una década desarrolló distintos proyectos de observación, compartió con sus colegas largas temporadas en esa área natural de Puerto Rico que alberga toneladas de acero, hoy enmarañadas. “Fui por primera vez en 1979, siendo investigador posdoctoral en la Universidad de Maryland. Envié una propuesta para observar durante dos semanas, varias horas por día y obtuve el financiamiento para hacerlo. Luego, durante más de diez años fui regularmente por diferentes proyectos. La última vez que estuve fue en 1989, pero nunca perdí contacto con la gente del lugar, y sé que los dos últimos años han sido muy duros”, dice Mirabel, conmocionado, luego de ver las imágenes del colapso del telescopio que se difundieron por las redes sociales.

Mirabel es Investigador en el Instituto de Astronomía Física del Espacio de UBA-CONICET, fue director de los Observatorios Europeos del Sur (ESO) en Chile y director de Investigaciones en el departamento de astrofísica de la Comisión de Energía Atómica de Francia. Es miembro de la Academia Nacional de Ciencias Exactas, Físicas y Naturales.

-¿Por qué este radiotelescopio era tan especial?

-Esencialmente por la superficie colectora, la cual era equivalente a la suma de todos los radiotelescopios del mundo. El diámetro es de 305 metros, la circunferencia es de casi un kilómetro. Lo recuerdo bien porque hacíamos ejercicio ahí, corríamos alrededor del plato. La superficie colectora de radiación es muy grande y por consiguiente se podían detectar señales muy débiles que otros radiotelescopios no pueden. Para nuestro proyecto de observación de galaxias infrarrojas ultraluminosas, en unos pocos minutos logramos un muy buen espectro, en otros esa observación llevaba horas. Pero, además, es un radiotelescopio que no sólo funcionaba como receptor sino también como radar, el radar más poderoso del mundo, por eso frecuentemente lo utilizaba la NASA para dar seguimiento a sondas espaciales en el espacio interplanetario. También se utilizaba como alarma sobre posibles asteroides que podrían colisionar con la Tierra. Es decir, era un instrumento de una versatilidad muy grande, era único.

-Ese plato que usted menciona era básicamente una malla de alambre sobre una depresión del terreno, y en altura había una antena sostenida por tres cables de acero, la estructura que vimos derrumbarse. ¿Cómo funcionaba?

-En este radiotelescopio, en lugar de mover el espejo primario, se mueve el foco sobre una plataforma en altura, y así se simula el movimiento de esa malla receptora, y dependiendo de la declinación de las fuentes se podía observar cada objetivo por un intervalo máximo de dos horas. La plataforma colapsó, este problema comienza a ser agudo cuando se proyecta la instalación de más instrumentos de hasta 200 toneladas sobre la plataforma y uno de los cables empezó a deshilacharse.

-¿Cuáles cree que han sido los descubrimientos más importantes que se lograron gracias al radiotelescopio de Arecibo?

-Según mi parecer, el más importante fue el que dio lugar al premio Nobel de 1993, a Joseph Taylor y Russell Hulse a partir del descubrimiento de un sistema binario de púlsares. Conocí a Taylor años antes de que él ganara el Premio Nobel. Pasó su año sabático en Arecibo, trabajando muchas horas diarias en un sistema instrumental de detección muy sofisticado para la resolución temporal de señales pulsantes y escribiendo un libro. Cuando yo era estudiante de licenciatura se descubrieron los púlsares por primera vez y por la precisión de los períodos de pulsación se llegó a creer que eran los hombres verdes enviándonos señales, no se conocía ningún fenómeno natural que pudiera producir ese tipo de señales. Fue -en 1974- el profesor Carlos Jaschek, del Observatorio de La Plata, quien nos comentó la noticia. Durante las observaciones de ese púlsar binario, Taylor fue constatando que el período orbital entre las dos estrellas de neutrones decrecía con el tiempo, lo que quiere decir que había una pérdida de energía orbital que se producía por la radiación de ondas gravitacionales. El Nobel 2017 fue entregado por esta detección indirecta de ondas gravitacionales a LIGO. El otro gran descubrimiento fue la observación de un par de objetos alrededor de un púlsar que llamaron planetas porque producían un tironeo de la estrella de neutrones y, por consiguiente, variaciones en los pulsos de los púlsares asociados a la estrella de neutrones. Esto fue un descubrimiento muy importante, pero quizás no con el impacto del descubrimiento posterior de un sistema planetario como se produjo más tarde por medio de observaciones ópticas. Además, Arecibo fue utilizado como radar para hacer la prospección de la superficie de Venus, un planeta con una atmósfera muy densa, y también como alarma de posibles asteroides que se acercan a la Tierra.

-Imagino que era un lugar único, también, para encontrarse con colegas y pasar temporadas de observación.

-Es un lugar muy especial. Aleksander Wolszczan, el polaco que descubrió el par de planetas asociados a un púlsar, era staff permanente de Arecibo, y cuando visité Varsovia para dar conferencias, descubrí que allí lo llamaban el Copérnico del siglo XX. También pude conversar con Michel Mayor, quien recibió el premio Nobel por el descubrimiento del primer sistema planetario extrasolar.

-Arecibo es muy importante para usted, para su carrera. ¿Cuáles han sido sus trabajos allí?

-Mi primer estudio fue sobre nubes de gas de hidrógeno atómico provenientes de las galaxias satélites llamadas “Nubes de Magallanes”. Ese gas cae hacia la Vía Láctea a velocidades de 400 km por segundo, y en aquella oportunidad encontré evidencia directa de la colisión de esas nubes de hidrógeno con la Vía Láctea. Esa fue la primera evidencia indirecta de la existencia de un medio intergaláctico de gas ionizado con temperaturas de cien mil grados Kelvin, muy difícil de detectar directamente, pero que en la actualidad se piensa constituye una fracción importante de la masa bariónica -materia- del universo. Pero mi proyecto más importante en el Observatorio de Arecibo vino después con el inicio del descubrimiento de un nuevo tipo de galaxias, muy extrañas por su forma irregular, que más tarde confirmé con mi colega Dave Sanders, de Caltech: eran galaxias en colisión en avanzado estado de fusión. Usando el satélite Infrared Astronomical Satellite (IRAS) de NASA, descubrimos que eran galaxias con radiación equivalente en energía a los cuásares, pero en el infrarrojo. Son galaxias ultraluminosas, en el infrarrojo radian tanto como un millón de millones de soles pero no se detectan de forma óptica, son oscuras a los ojos. Este fue mi proyecto más productivo en Arecibo porque significó la apertura de nuevos horizontes de investigación.

-¿Qué piensa que sucederá con el resto del Observatorio y los grupos de trabajo que estaban allí?

-Hay proyectos que solo podían ser desarrollados en Arecibo y serán definitivamente abortados, a menos que puedan ser continuados con el nuevo radiotelescopio FAST de 500 metros de diámetro en China. Supongo que una fracción importante de los trabajadores del observatorio perderá su trabajo. Con seguridad será una gran pérdida a nivel educativo y recursos para los habitantes de la región de Arecibo y Puerto Rico en general.

*Por Carlos Acha - Departamento de Física, UBA & IFIBA-CONICET

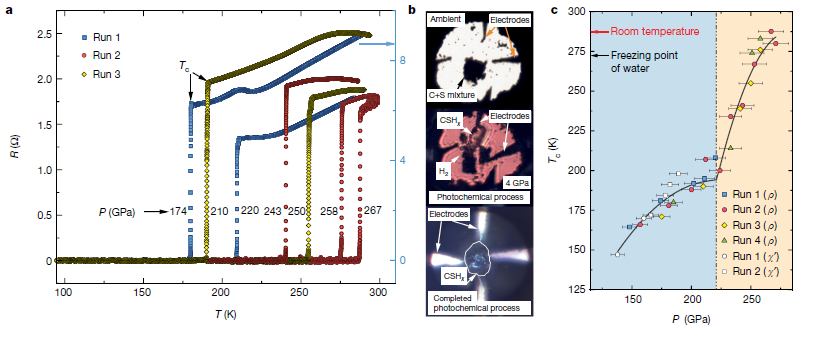

En un trabajo que acaba de ser publicado por la revista Nature [Snider, E. et al. Nature 586, 373–377 (2020)], Ranga Dias y colaboradores lograron materializar un sueño largamente buscado: ¡obtuvieron superconductividad a temperatura ambiente! Necesitaron aplicar presiones de 267 GPa (más de 2 millones de atmósferas) sobre un compuesto a base de Azufre, Carbono e Hidrógeno para lograr observar una transición superconductora resistiva a 15 °C. También vieron que esta transición no cambia al variar la corriente aplicada (descartando así que se tratara de una fase minoritaria) y que se corre a menores temperaturas al aplicar un campo magnético intenso. Adicionalmente lograron medir un apantallamiento magnético por susceptibilidad alterna. Este conjunto de pruebas, reproducidas para varias docenas de muestras, hace pensar que no se trata de un error y que efectivamente los investigadores lograron que el material alcance un estado superconductor, sin que sea uno de los artificios que pudiera aportar, por ejemplo, una transición de fase inducida por presión, dando a lugar a un cambio abrupto en la conducción eléctrica, sin que en realidad haya de por medio una transición superconductora asociada.

Por ahora los investigadores desconocen la estequiometría y estructura cristalina del compuesto que sintetizaron fotoquímicamente entre los dos yunques de diamante que emplearon para aplicar estas increíbles presiones al material. Allí mezclaron H2 con S y C, aplicaron una presión de 4 GPa e iluminaron con un láser de 532 nm durante varias horas. A esta presión la longitud de onda de la luz incidente rompe las uniones del S y permite que forme otras estructuras, reaccionando con el H2 para formar H3S. Ajustando la iluminación del láser y la presión aplicada observaron la formación de un cristal homogéneo y transparente en el que, mediante espectroscopía Raman, verificaron la no existencia de restos de S o de C sin reaccionar. También confirmaron que el material formado es inestable a presiones menores a los 10 GPa y que transiciona a una fase metálica a partir de los 60 GPa.

Este logro, tan buscado desde el descubrimiento de la superconductividad, se obtuvo tras una serie de investigaciones, iniciadas hace menos de 10 años en hidruros con alto contenido de H2, con la idea de que la superconductividad podría desarrollarse a temperaturas no tan bajas como las requeridas usualmente. Esto sería posible gracias al fuerte acoplamiento entre los electrones y las vibraciones de la red que se puede obtener en el H2 bajo presión. Este trabajo muestra que el estado superconductor puede observarse a temperaturas tan altas como temperatura ambiente y no resulta obvio predecir cuál será la máxima temperatura para la que se observe superconductividad bajo estas condiciones extremas.

Un poco de historia

A principios del siglo pasado (1911), Kamerlingh Onnes y colaboradores se preguntaban cómo sería la conductividad eléctrica de un metal a bajas temperaturas: ellos se imaginaban que los electrones, en buena parte responsables de la conducción eléctrica, se comportarían como un gas, condensándose a temperaturas suficientemente bajas. Así, los portadores de carga perderían movilidad, y el metal se convertiría en un mal conductor, un aislante. Estas ideas, junto con la conjunción tecnológica de su capacidad de licuar Helio y la de poder contar con recipientes para almacenarlo durante un tiempo razonable, -gracias a los termos inventados por el señor Dewar-, les permitieron realizar el experimento.

Tremenda habrá sido su sorpresa al descubrir que el mercurio, por debajo de una temperatura llamada “crítica” (Tc), cercana a los 4 K (-269 °C), tenía un comportamiento totalmente opuesto al esperado: se convertía en un conductor perfecto, es decir ¡su resistencia eléctrica se hacía literalmente cero! Esto resultó ser el descubrimiento de un nuevo estado electrónico de la materia, que en ese momento llamaron “superconductividad”. Desde entonces, el estudio de los materiales superconductores y de sus propiedades ha sido un campo de mucho interés científico y tecnológico.

Con el devenir de los años se develaron muchas propiedades adicionales de los superconductores: 30 años luego del descubrimiento de Onnes, se supo que la superconductividad era más que la conducción perfecta, ya que para que un material pertenezca al “club” también tiene que ser un diamagneto perfecto, al menos bajo ciertas condiciones[i]. Esto quiere decir que al someterlo a un campo magnético el superconductor dispone, con cierta gratuidad, de corrientes eléctricas para apantallar el campo magnético y hacerlo nulo en su interior (B=0, el llamado efecto Meissner). Se habló entonces de superconductores de tipo I y II, siendo los primeros los que frente a un campo magnético creciente mantienen heroicamente B=0, hasta un valor crítico en el que dejan de ser superconductores, y los segundos aquellos que dejan entrar cuantos de flujo magnético (vórtices) conformando una red y manteniéndose en un estado superconductor mixto con propiedades muy interesantes. Y así se fue entendiendo cada vez más de los superconductores, tanto mediante el uso de descripciones macroscópicas de la transición de fase al estado superconductor (teoría de Ginzburg-Landau) como gracias al desarrollo de una teoría microscópica que describe la aparición del estado superconductor gracias a la existencia de una interacción atractiva entre los electrones (teoría BCS[ii]). Se descubrieron propiedades muy llamativas como las que se observan en interfaces entre superconductores y aislantes (efecto Josephson), o entre superconductores y metales normales (efecto de proximidad), entre otras muchas cuestiones que no vamos a describir aquí.

Una de las aplicaciones de los superconductores que generó mucho interés, ya desde los primeros años de su descubrimiento, fue la de aprovechar su resistencia nula para transportar grandes corrientes eléctricas. En efecto, los metales normales tienen el mal hábito de perder energía como calor cuando circula a través de ellos una corriente (efecto Joule). Por ello, los superconductores serían ideales para su uso en cables de alta tensión o en bobinas, tanto de motores como de solenoides para la generación de grandes campos magnéticos. De hecho, esta es la aplicación industrial más frecuente de los superconductores: la producción de campos magnéticos altos y tremendamente estables que encontramos en los equipos médicos de imágenes por RMN. También existen trenes de alta velocidad levitados e impulsados gracias al uso de bobinados superconductores. El problema es que para que el superconductor funcione como tal, es necesario enfriarlo por debajo de su Tc. Si alcanzar estas temperaturas requiere por ejemplo del uso de Helio líquido, esto impone costos altos y serias limitaciones para el uso masivo que quisiéramos darles. Es por eso que los trenes levitados (Maglevs) son una rareza muy costosa que sólo puede verse en contados lugares.

Desde los inicios de la superconductividad, los investigadores se han desvelado por encontrar materiales cuya Tc sea lo más alta posible. Sin embargo, la teoría BCS indicaba que no sería posible tener superconductores con una temperatura crítica mayor a 30 K, ya que la interacción atractiva entre electrones requerida por la teoría, por su origen ligado a las vibraciones de la red de iones, se vería disminuida completamente al aumentar la temperatura por arriba de ese límite. Dentro de los intentos por favorecer todos los parámetros que según la teoría BCS darían lugar a la mayor Tc posible, en 1986 los investigadores Bednorz y Muller[iii] se toparon con un importante hallazgo: un superconductor de más de 30 K, que les valdría el premio Nobel por la gran revolución que desencadenó. De esta manera, los cupratos con estructura de perovskita dieron lugar a una nueva familia de superconductores que no respondía a la teoría BCS. Se los llamó superconductores de alta temperatura crítica.

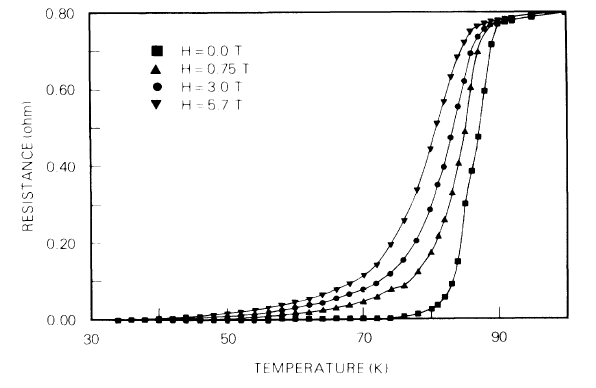

Durante toda la década de los 90’s este tema acaparó a la mayor parte de la comunidad de materia condensada, que se orientó a entender esta nueva superconductividad y a generar nuevos materiales que rompieran el récord de la mayor Tc. Experimentos de altas presiones realizados por Paul Chu de la Universidad de Houston mostraron que al comprimir al superconductor estudiado por Bednorz y Muller (LaBaCuO) la Tc aumentaba sensiblemente. Se buscó entonces comprimir la estructura con reemplazos químicos, generando el mismo efecto que con la presión externa. Así, reemplazando el La por un átomo de menor radio (Y), Chu y colaboradores[iv] lograron sintetizar el primer superconductor (YBaCu3O7, Tc=90 K) que “sólo” requería ser enfriado mediante nitrógeno líquido (-196 °C) para ser superconductor. De este modo, con el descubrimiento de nuevos materiales superconductores basados en cupratos, en un período de 5 años, la Tc aumentó más de lo que lo había hecho en cerca de 90 años de investigaciones. El sueño de lograr tener superconductividad a temperatura ambiente tenía resultados alentadores (Tc=138 K para un cuprato basado en Hg – 166 K para un compuesto similar a presiones de 23 GPa, es decir a 230.000 atmósferas*[v]), cuya concreción se haría aún esquiva por un tiempo.

Primera transición superconductora por encima de la temperatura de ebullición del nitrógeno líquido obtenida en compuesto YBa2Cu3O7. Se observa también los efectos del campo magnético aplicado. (fuente: https://journals.aps.org/prl/pdf/10.1103/PhysRevLett.58.908).

Por otra parte, en 1968 Neil Ashcroft indicó que el hidrógeno, bajo altísimas presiones (¡más de 4 millones de atmósferas!), podría llegar a ser superconductor a temperatura ambiente, debido al fuerte acoplamiento entre sus electrones y las vibraciones de la red, que es uno de los ingredientes necesarios que indica la teoría BCS para lograr altas temperaturas críticas. Se empezó a pensar en la estrategia de pre-comprimir al hidrógeno mediante reemplazos químicos de manera de reducir las presiones necesarias para lograr la tan buscada meta. A partir de 2004 muchos trabajos teóricos indicaron cuáles compuestos serían posibles candidatos a mantener su estructura estable a tan altas presiones y lograr el estado superconductor a muy alta Tc. Así, algunos grupos que desarrollaron la capacidad de realizar experimentos de conducción eléctrica bajo presiones mayores a los 100 GPa, al comprimir muestras entre yunques de diamante de secciones milimétricas, se concentraron en estudiar la posible superconductividad de compuestos ricos en hidrógeno (H3S, CaH6, LaH10, entre muchos otros) bajo presión. En 2016 Drozdov y colaboradores[vi] lograron medir una Tc que superó la barrera de los 200 K aplicando 200 GPa en H3S, y la existencia de un campo crítico. También mostraron la existencia de efecto isotópico, que es una de las huellas digitales de la superconductividad que responde a la teoría BCS. La Tc bajo altísimas presiones fue incrementándose así al estudiar distintos compuestos ricos en hidrógeno, trepando hasta cerca de los -20 °C.

Evolución de la Tc superconductora a través de los años (fuente: https://www.chemistryworld.com).

Finalmente, tras realizar una síntesis fotoquímica in situ (en el espacio entre dos yunques de diamante) de una mezcla de metano con los precursores de H3S, Ranga Dias y colaboradores de la Universidad de Rochester[vii] lograron la tan ansiada meta: observar superconductividad a 15 °C. Dieron pruebas contundentes de ello ya que observaron tanto la transición resistiva y su sensibilidad al campo magnético aplicado como el apantallamiento magnético esperado. Es cierto que tuvieron que aplicar presiones de 267 GPa y que por ahora desconocen la composición química y la estructura del compuesto sintetizado, aunque realizaron estudios espectroscópicos (Raman) que les confirmaron que, al producirse la síntesis del material, los elementos C-H-S se incorporaron efectivamente en una estructura cristalina que alcanza un estado metálico sin descomponerse.

Lograr superconductividad a temperatura ambiente bajo muy altas presiones no permite realizar ninguna de las aplicaciones prácticas para las que se soñó esta superconductividad. Sin embargo, además del interés científico que implica su descubrimiento en cuanto a ciencia básica, es la prueba concreta de que el estado superconductor de un material puede lograrse a temperaturas tan altas como la temperatura ambiente. Será entonces un desafío para la ciencia de materiales lograr encontrar la manera de sintetizar algún material que recree las condiciones logradas en los compuestos ricos en hidrógeno bajo los yunques de diamante. Lo que se creía imposible se ha logrado. Hay entonces renovadas esperanzas para imaginar que en algún tiempo podremos contar con materiales superconductores que, sin aplicarles presión, nos permitan sacar un gran partido de sus sorprendentes propiedades.

[i] Meissner, W.; Ochsenfeld, R. (1933), Naturwissenschaften. 21 (44): 787–788.

[ii] Bardeen, J.; Cooper, L. N.; Schrieffer, J. R. (1957), Physical Review. 106 (1): 162–164.

[iii] Bednorz, J. G. and Müller, K. A. (1986), Z. Phys. B 64, 189.

[iv] M. K. Wu, J. R. Ashburn, C. J. Torng, P. H. Hor, R. L. Meng, L. Gao, Z. J. Huang, Y. Q. Wang, and C. W. Chu

Phys. Rev. Lett. 58, 908.

[v] Durante casi 10 años este récord de Tc estuvo asociado a una investigación realizada en colaboración entre el LBT del DF y el CNRS de Grenoble: Monteverde, M.; Acha, C.; Núñez-Regueiro, M.; Pavlov, D.A.; Lokshin, K.A.; Putilin, S.N.; Antipov, E.V."High-pressure effects in fluorinated HgBa2Ca2Cu 3O8+δ" (2005) Europhysics Letters. 72(3):458-464

[vi] A.P. Drozdov, M.I. Eremets, I.A. Troyan, V. V. Ksenofontov, and S. I. Shylin. Conventional superconductivity at 203 K at high pressures. Nature, 525(73), 2015.

[vii] Snider, E. et al. Nature 586, 373–377 (2020).

*Por Ana Amador, profesora del DF, FCEN-UBA e investigadora del IFIBA, CONICET.

Entre el 7 y 9 de octubre nos conectamos a la reunión anual de la Sociedad Argentina de Neurociencias, la edición número 35 esta vez fue realizada de manera virtual. El evento convocó a más de 600 participantes. Un gran trabajo de la comisión organizadora y el compromiso de numerosos miembros de la sociedad de neurociencias hicieron posible una gran reunión: 6 charlas plenarias, 14 simposios, 22 charlas de jóvenes investigadores, 46 comunicaciones orales y 277 posters.

Investigadores y docentes del DF participaron activamente, reforzando los lazos interdisciplinarios en neurociencias. Enzo Tagliazucchi (profesor del DF e investigador del IFIBA) organizó el simposio “Neural correlates of dreaming and dreamlike states” (1) y Juan E. Kamienkowski (JTP del DF e investigador del ICC) organizó el simposio “Representation of language networks. A talk between the Brain and Artificial Intelligence” (2). En mi caso, organicé el simposio “Auditory processing, vocal production and motor control” (3). Estos espacios nos permitieron encontrarnos con invitados de diversas partes del mundo, y así aprovechamos la virtualidad para fortalecer los vínculos internacionales de la comunidad interdisciplinaria de neurociencias. https://san2020.saneurociencias.org.ar/symposia/

También participaron de la reunión científica fisiques y docentes que investigan y forman recursos humanos fuera del DF -con una perspectiva interdisciplinaria destacable-, como Mirta Villareal, Luz Bavassi y Verónica Pérez Schuster. El trabajo de estas docentes refuerza los vínculos interdisciplinarios del DF con la comunidad de neurociencias. Además de la presentación y discusión de los trabajos científicos, se realizó una actividad de género (4) y una discusión sobre políticas de Ciencia y Técnica en Argentina, donde el profesor del DF Fernando Stefani fue el disertante invitado (5).

En esta conferencia hubo también trabajos de jóvenes investigadores de nuestra institución que fueron destacados al ser elegidos como presentaciones orales: Santiago Boari (JTP del DF e investigador postdoctoral en el LSD) presentó una charla de joven investigador, mientras que Juan F. Döppler (JTP del DF y estudiante doctoral del LSD) y Laura Alethia de la Fuente (estudiante doctoral del COCUCO) presentaron comunicaciones orales. Varios estudiantes doctorales con lugar de investigación en el DF presentaron también sus trabajos de investigación en forma de póster.

Esta nutrida representación de físiques del DF en la reunión anual de la Sociedad Argentina de Neurociencias es el reflejo de una larga historia de trabajos interdisciplinarios en el área de biofísica en el DF, que comenzaron hace más de 20 años.

Página de la SAN: